背景&&解决问题

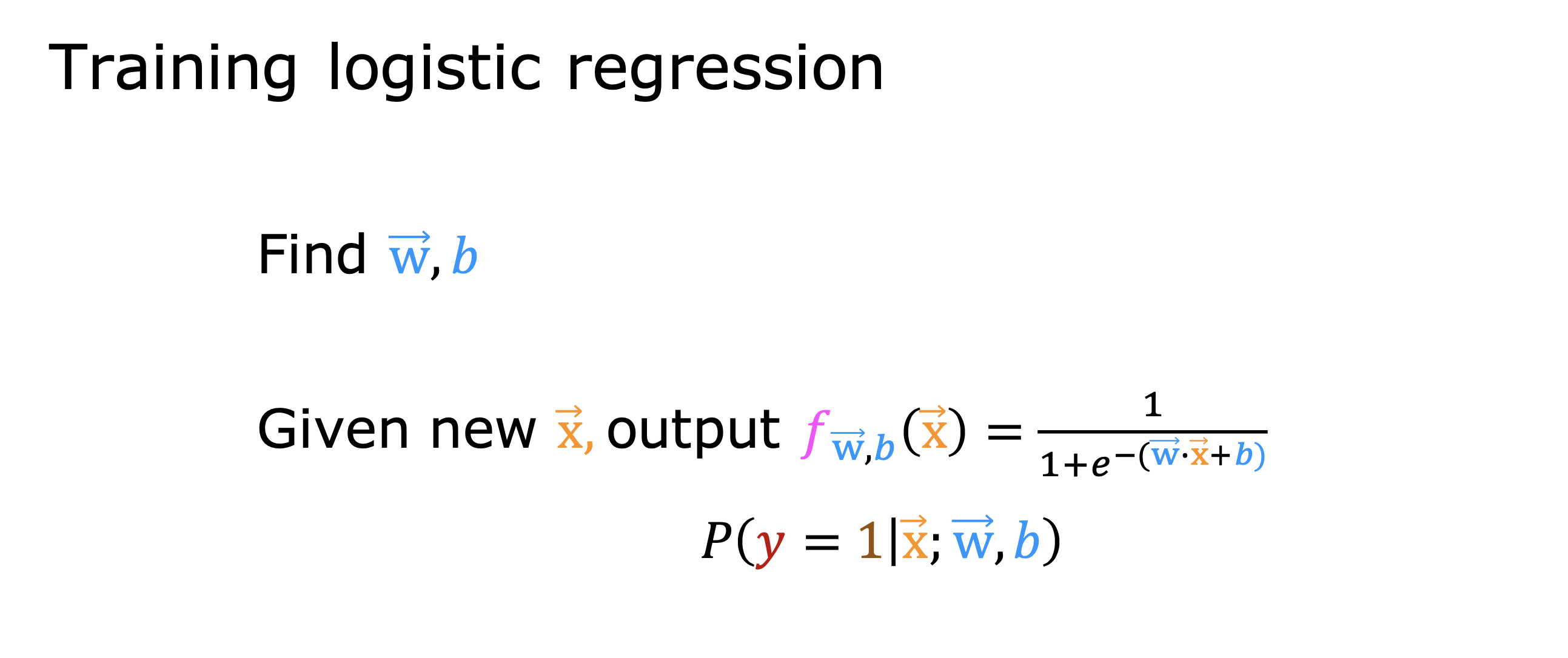

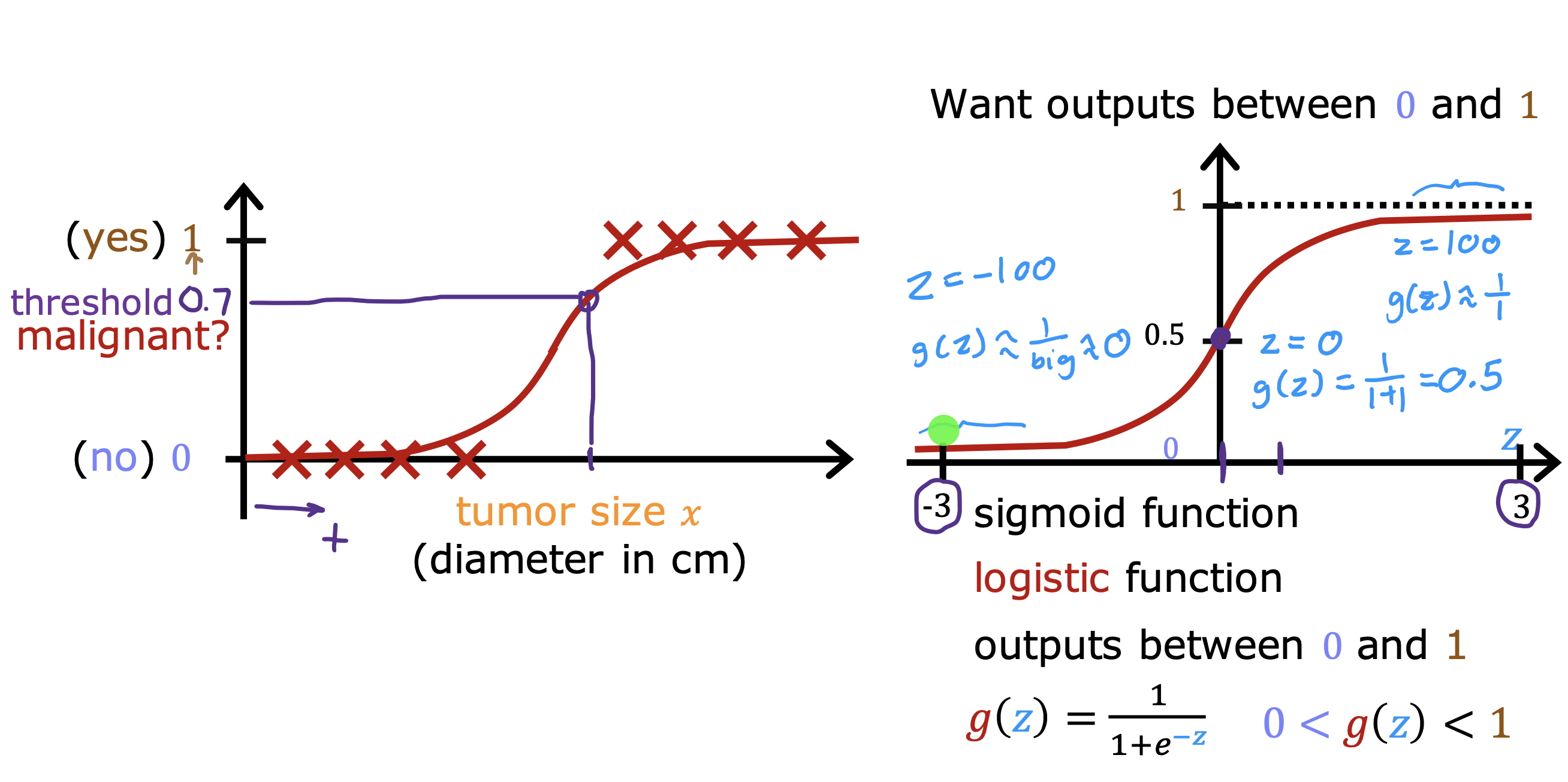

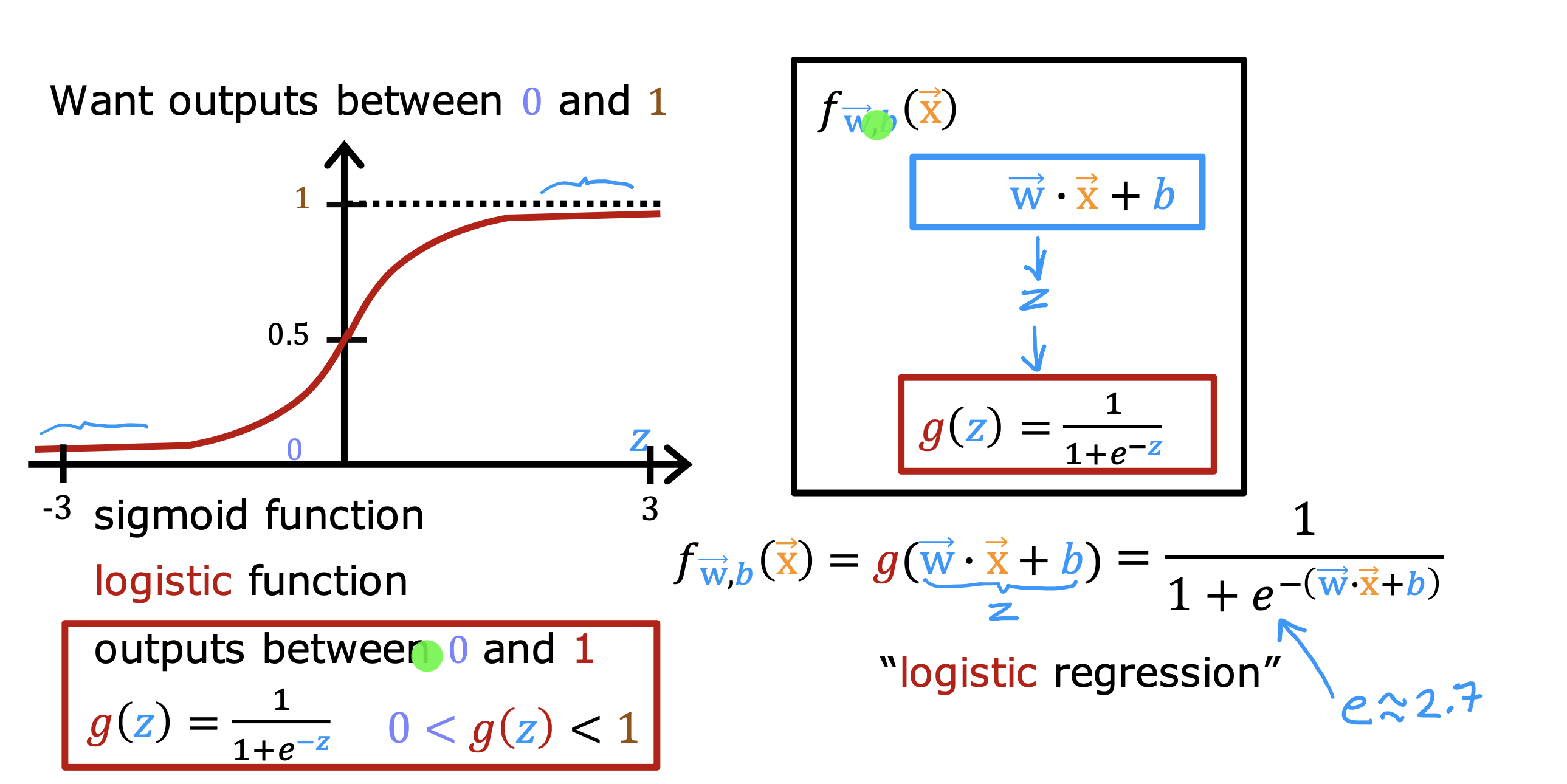

逻辑回归模型时一种解决二分类问题的算法

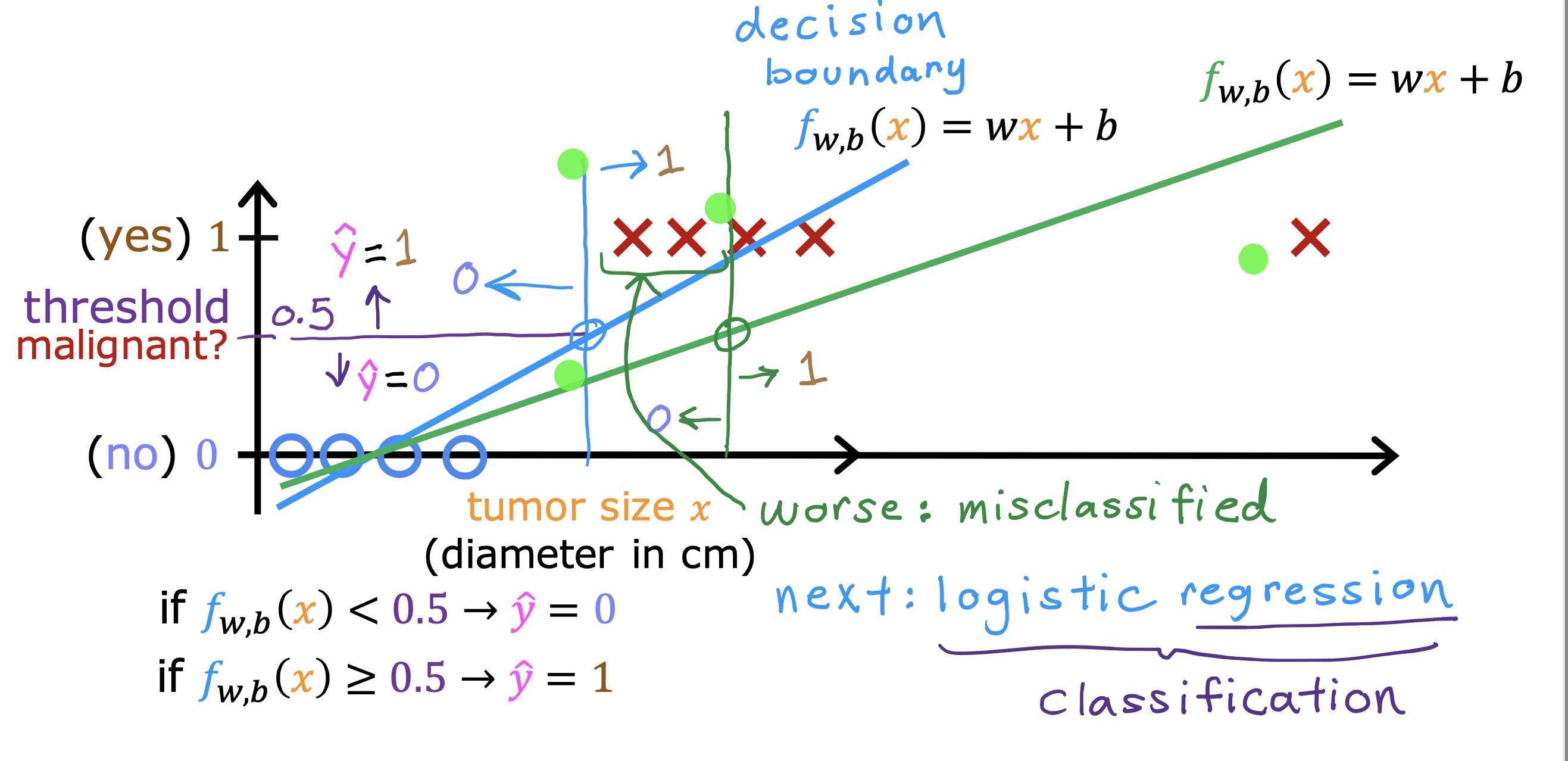

如果用线性回归去解决分类问题,会导致过拟合出现,每增加一个测试数据,都可能导致模型发生变化

通过使用sigmoid function函数,设置阈值,可以将线性回归产生的结果归类到两个结果上去

虽然目标是二分类,即结果只能是0 或者1

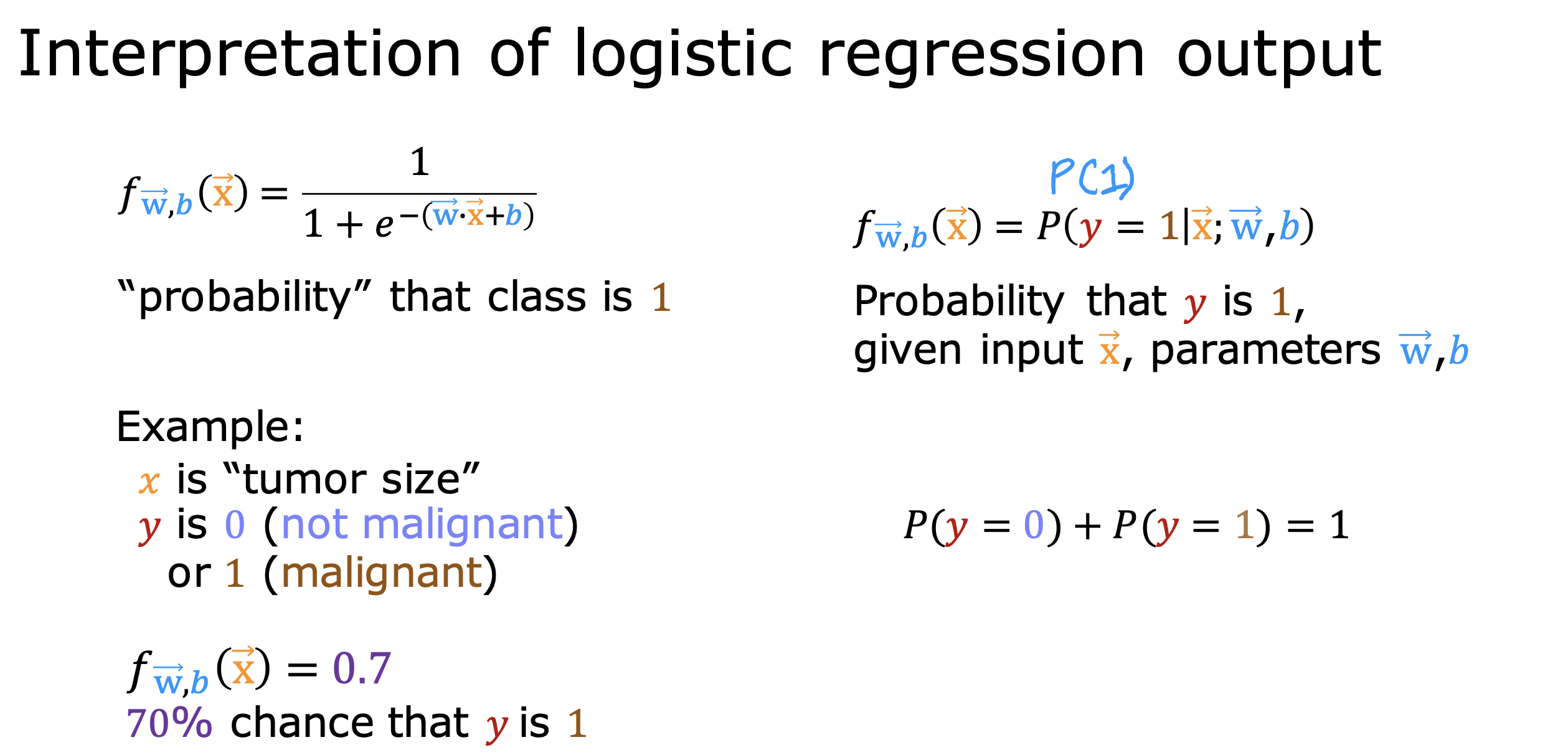

但是f(w,b) = g(w·x+b) 计算的结果值A只能无限接近这两个值

这里可以将A理解成结果是1 的可能性

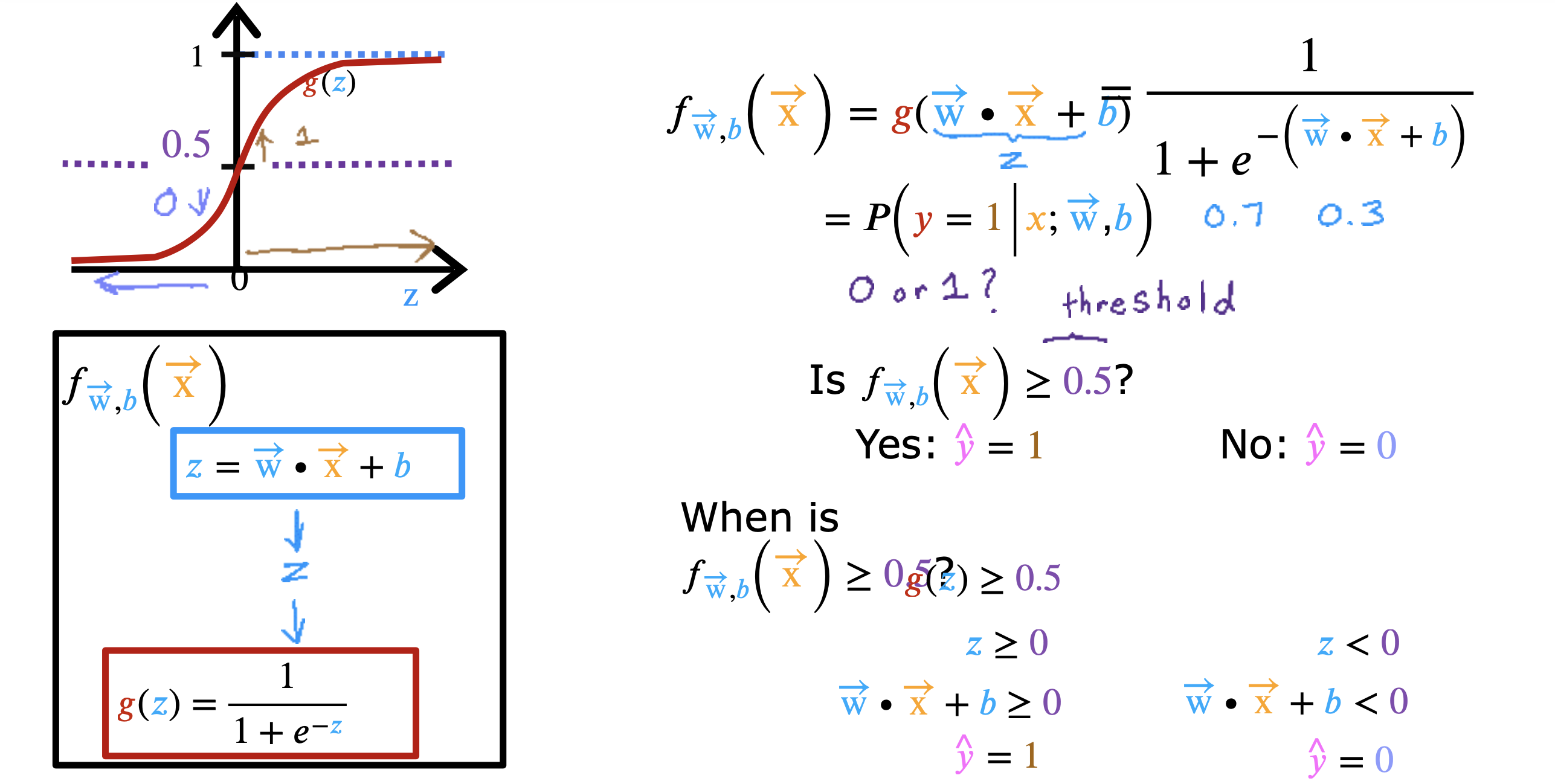

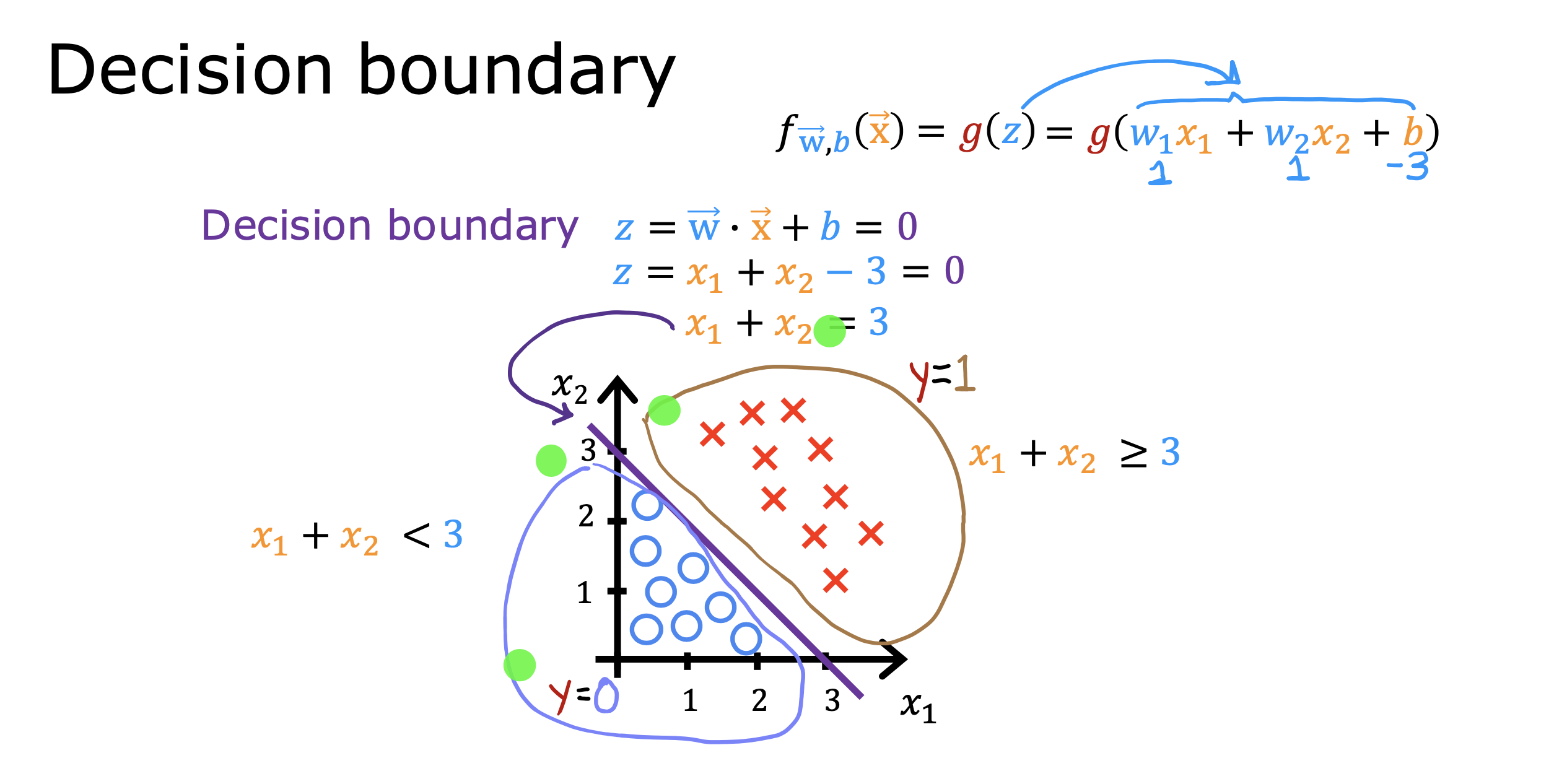

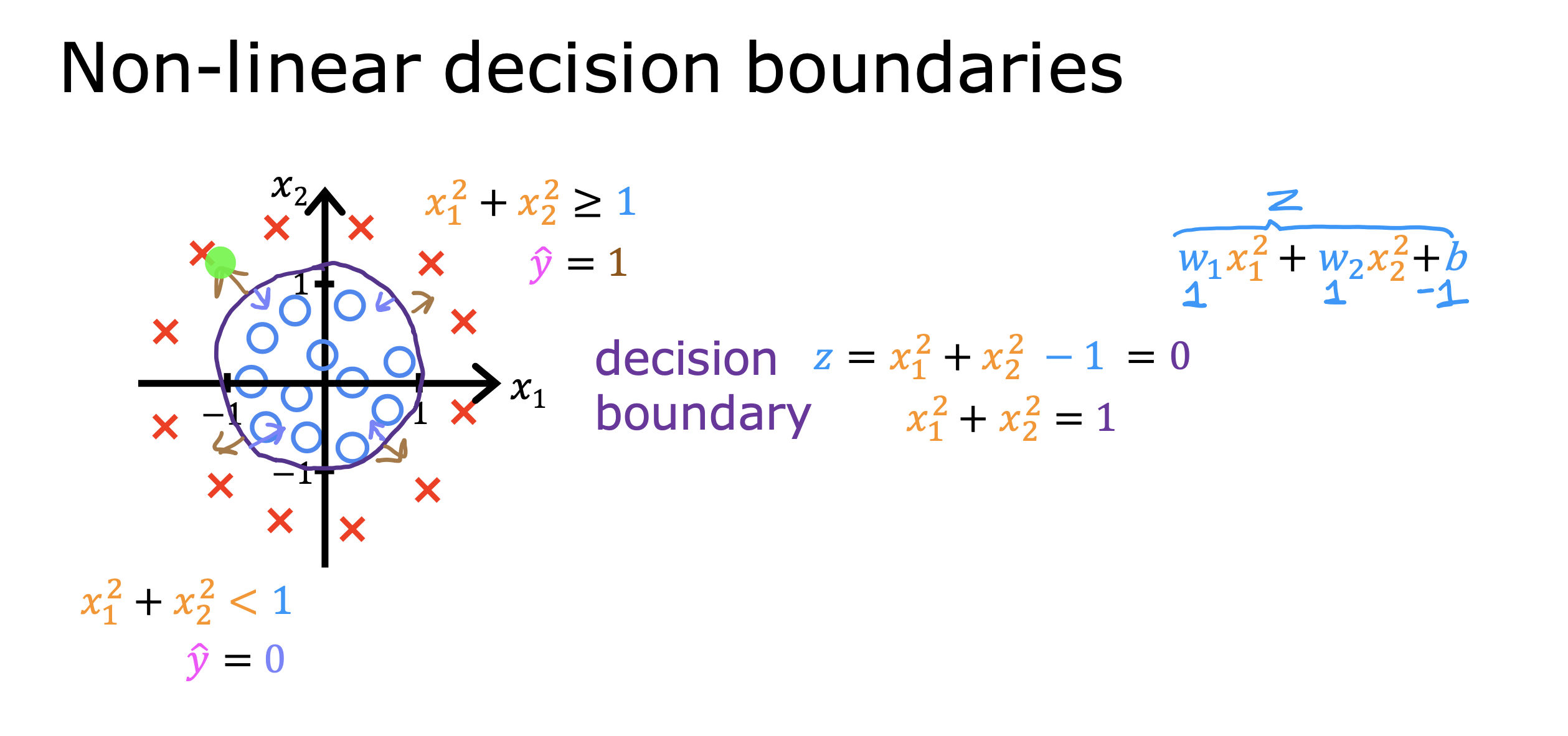

决策边界

在逻辑回归模型f(w,b) = g(w·x+b) 中

z = w·x+b 又称为 决策边界,将不同结果的数据在坐标系中进行隔离

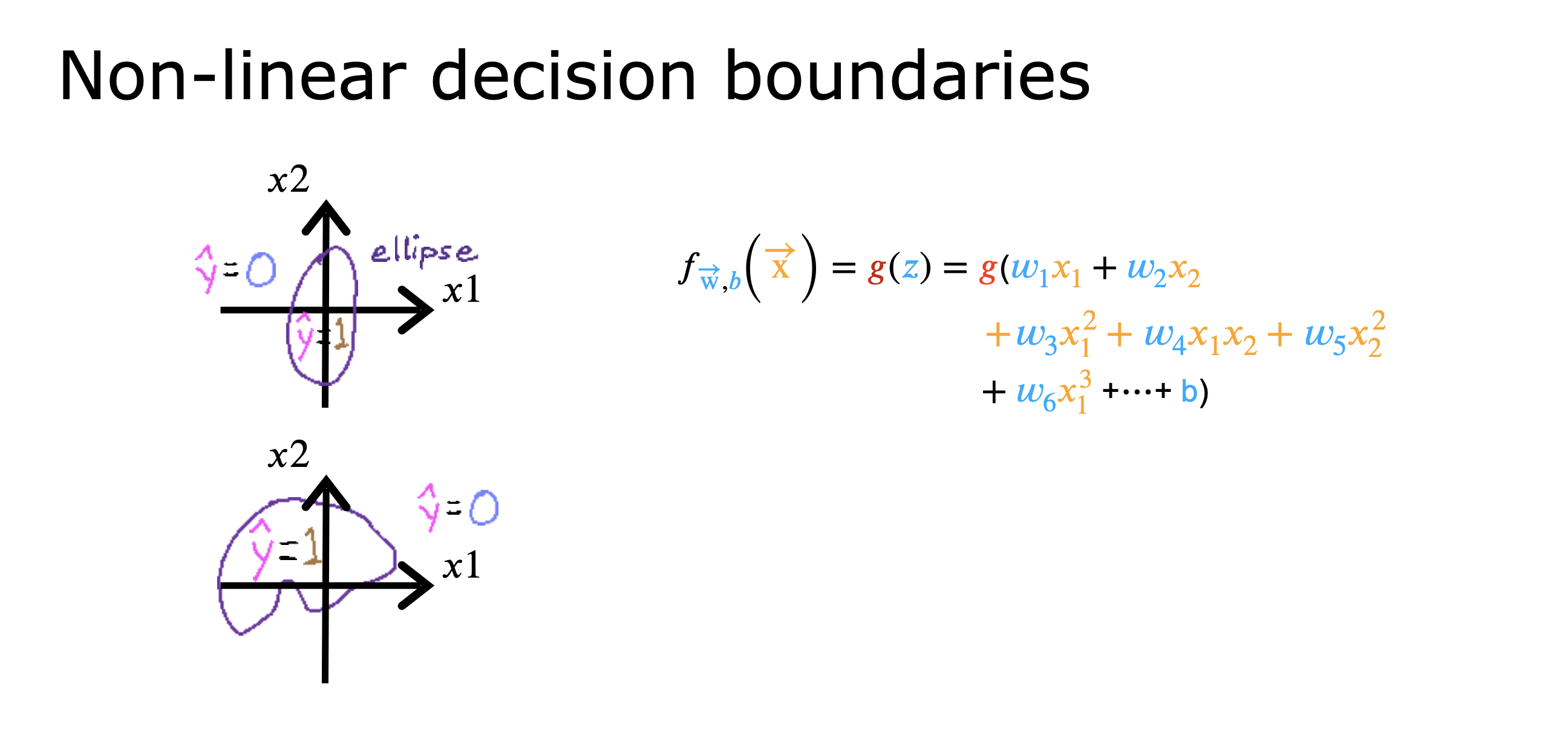

如果特征在z 中没有多项式运算,那么,得到的边界必定是直线的,但是如果有多项式,拿得到的边界线就是非线性的

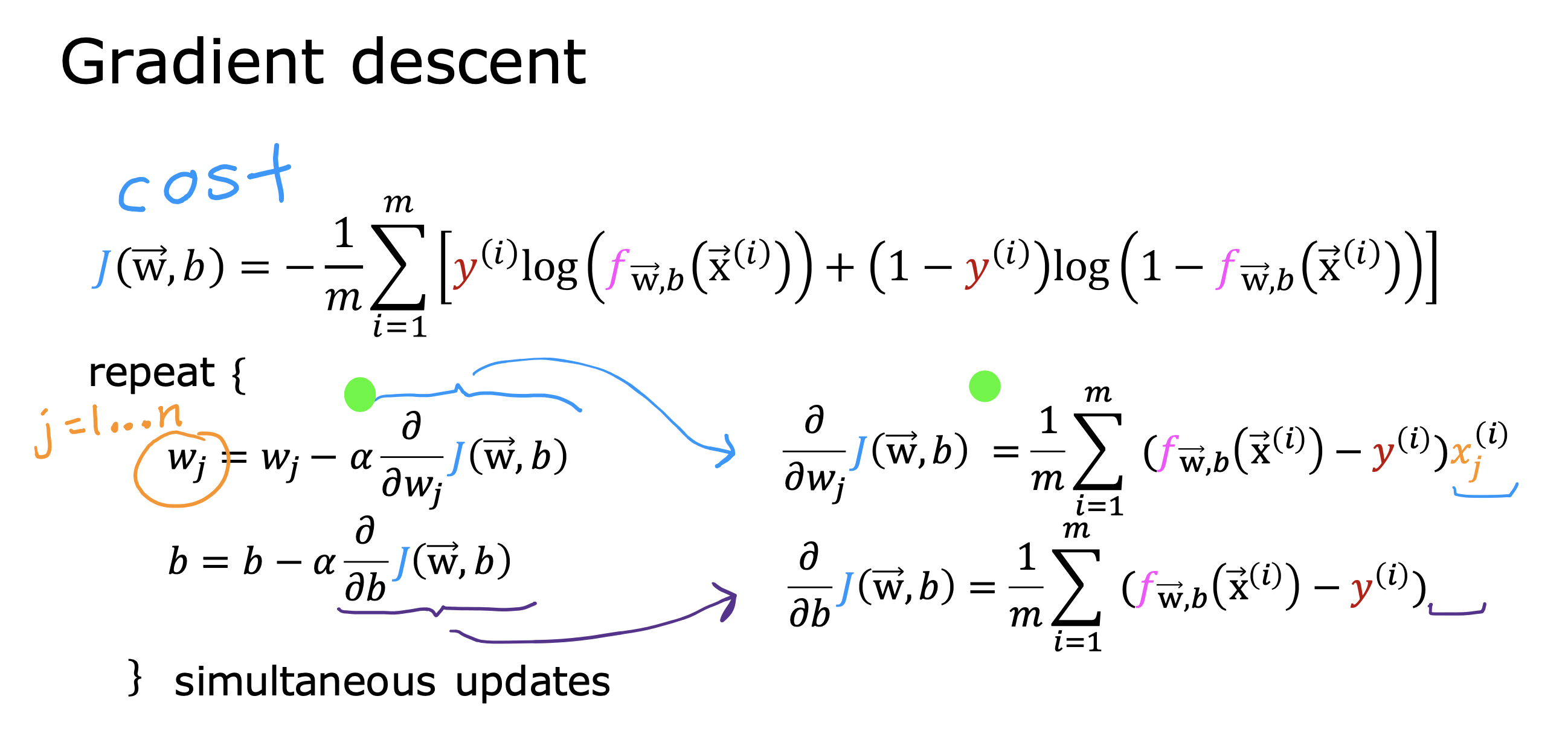

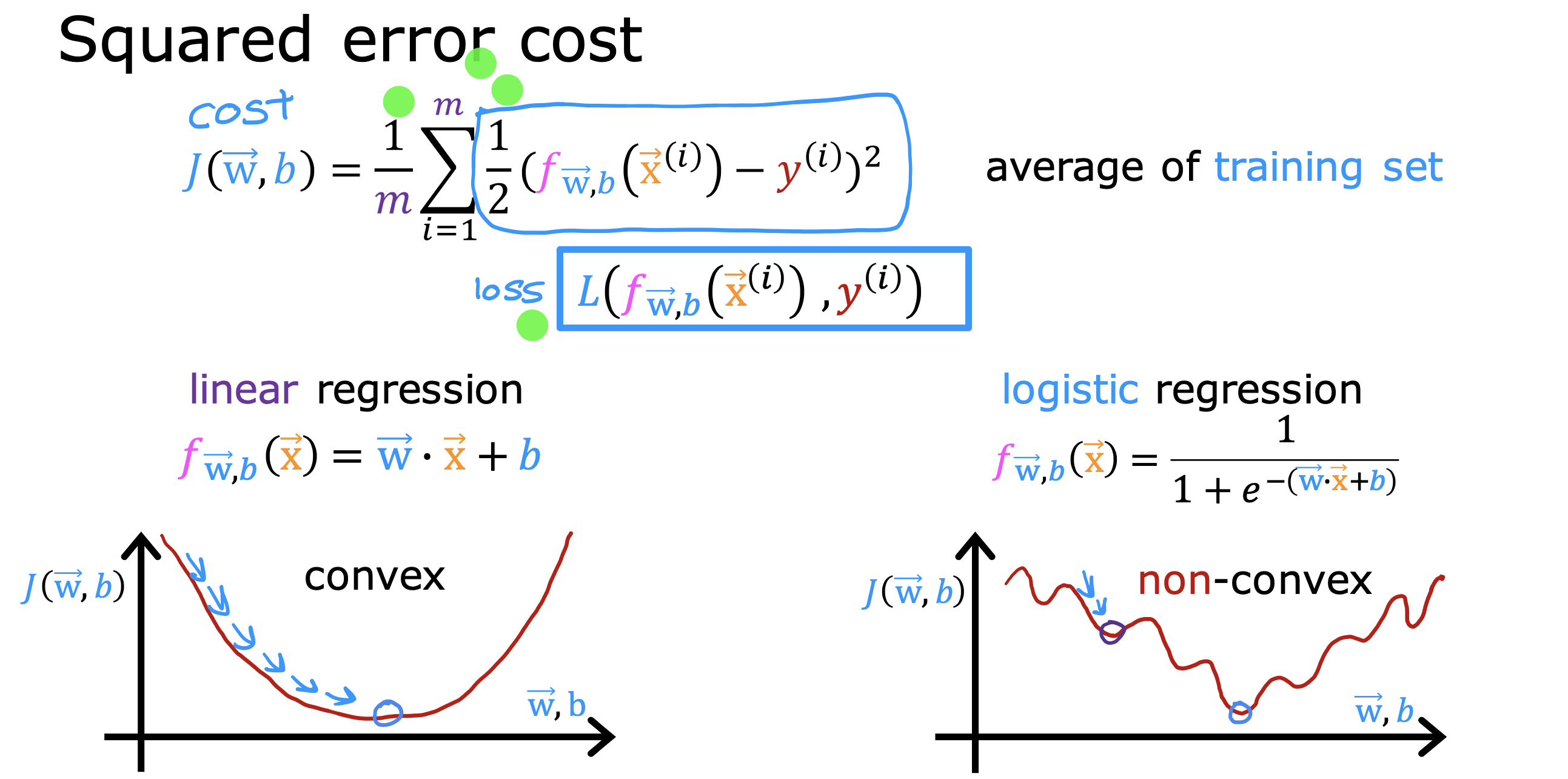

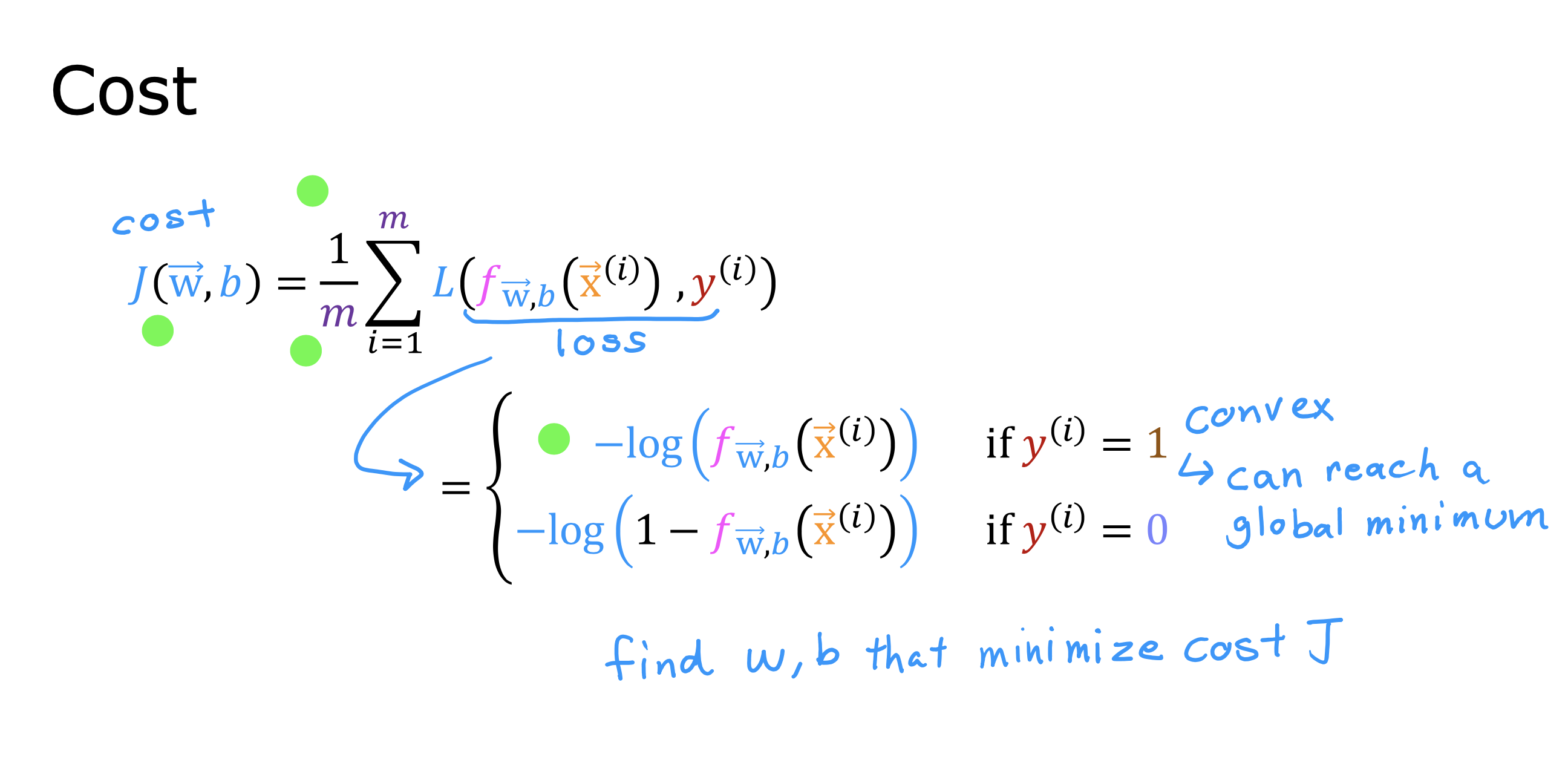

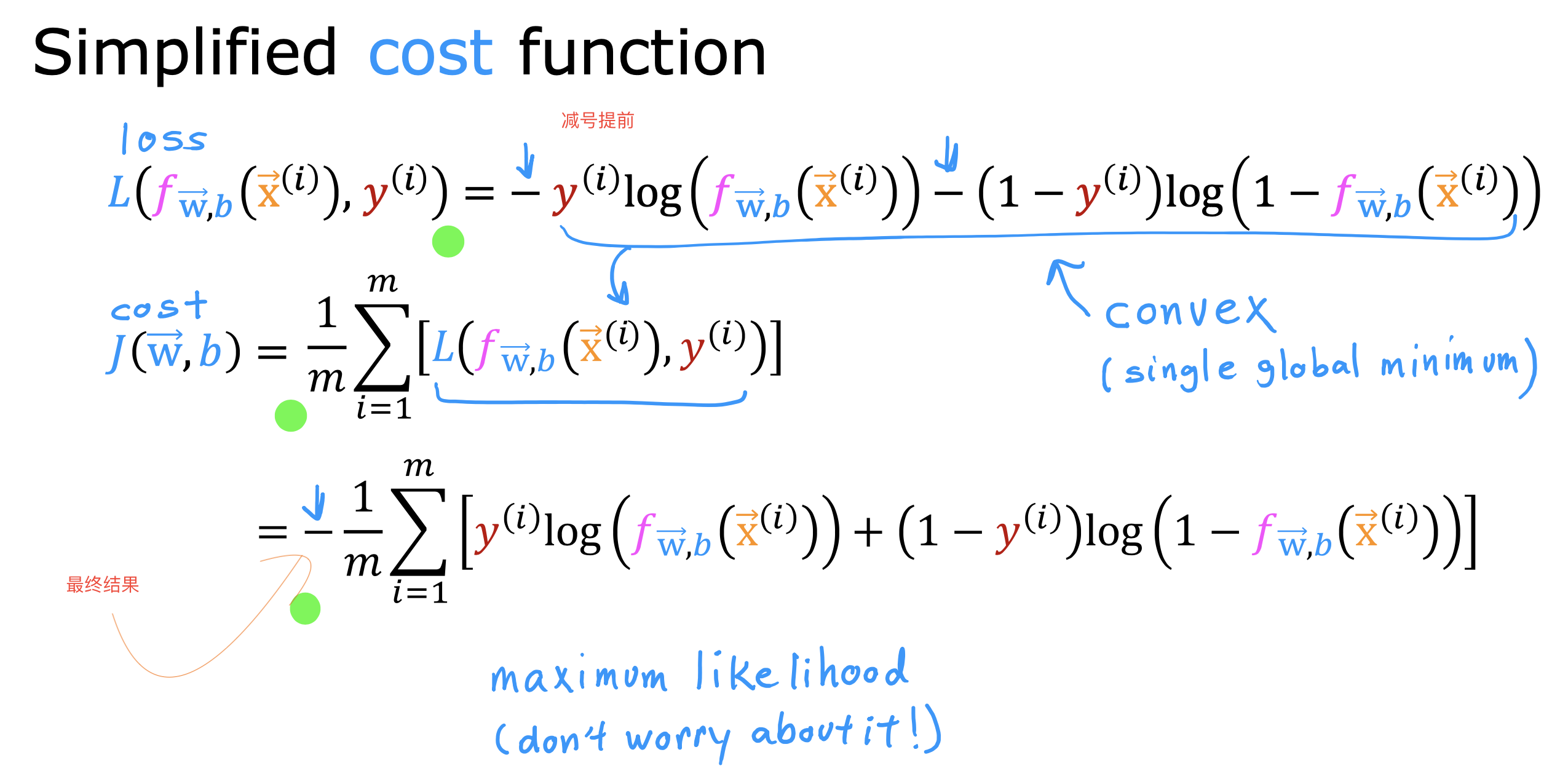

成本函数

线性回归的平方误差算法的成本函数在应用到逻辑回归时,会产生多个局部最小值,再用梯度下降的算法去找参数时,无法找到最小值

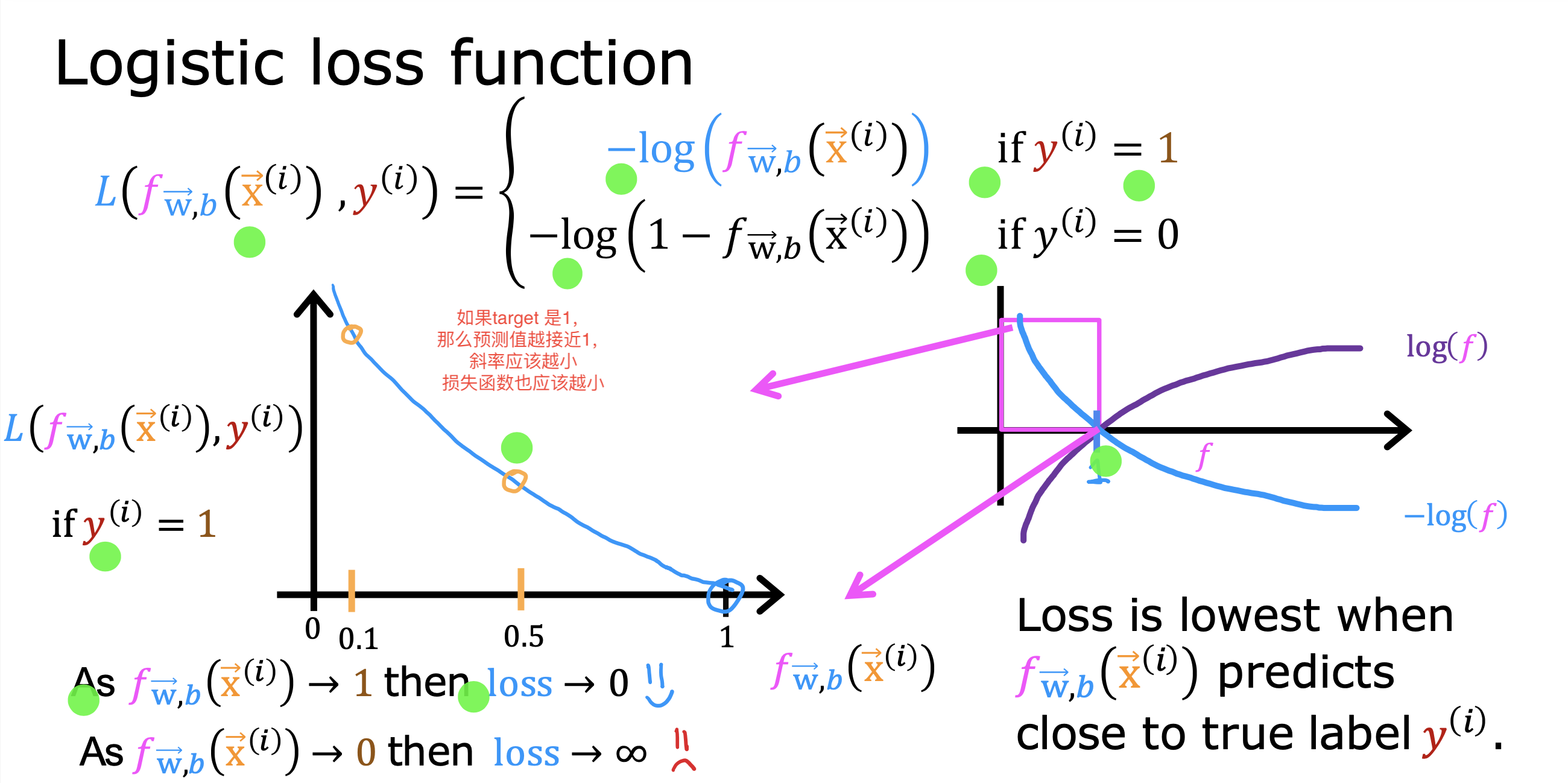

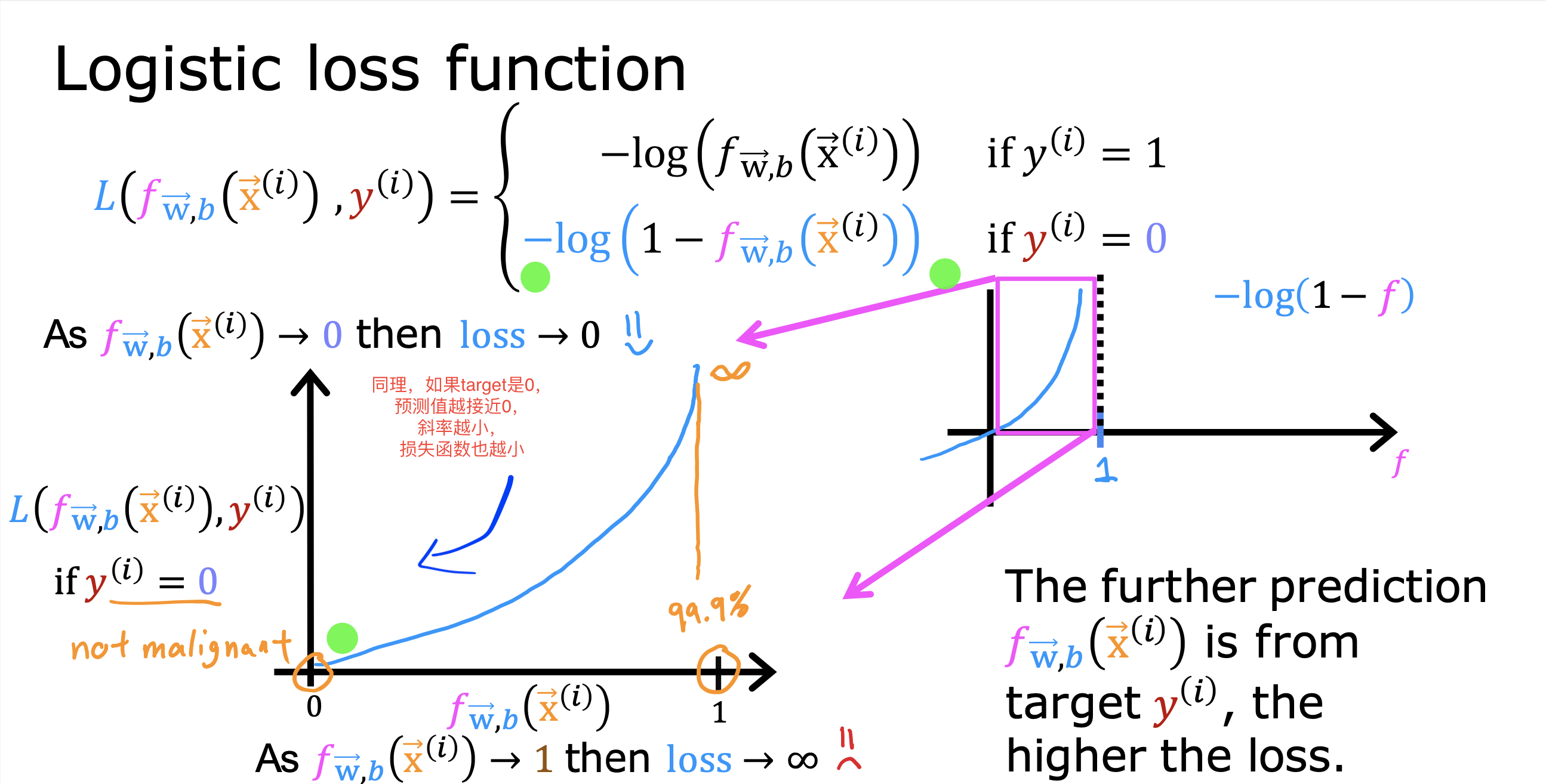

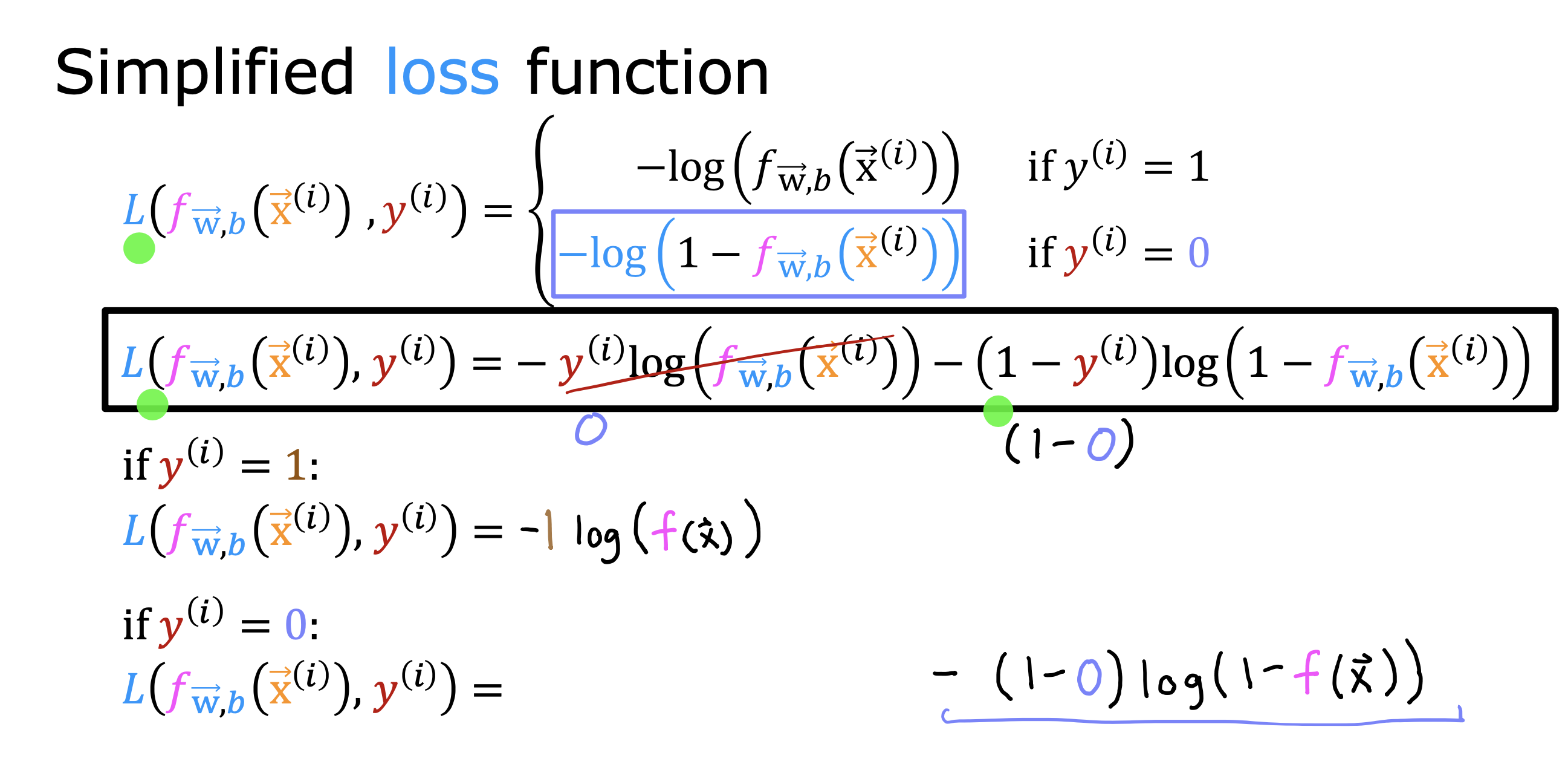

逻辑回归引入逻辑损失函数,根据单个数据集随参数变化的趋势,判断整体的变化趋势

操作就是将原本平方误差除以2的操作移到求和之前,单独计算每个特征值的部分就是损失函数

Logistic Regression uses a loss function more suited to the task of categorization where the target is 0 or 1 rather than any number.

these definitions are used:

Loss is a measure of the difference of a single example to its target value while the

Cost is a measure of the losses over the training set

下面是推导过程和最终的式子

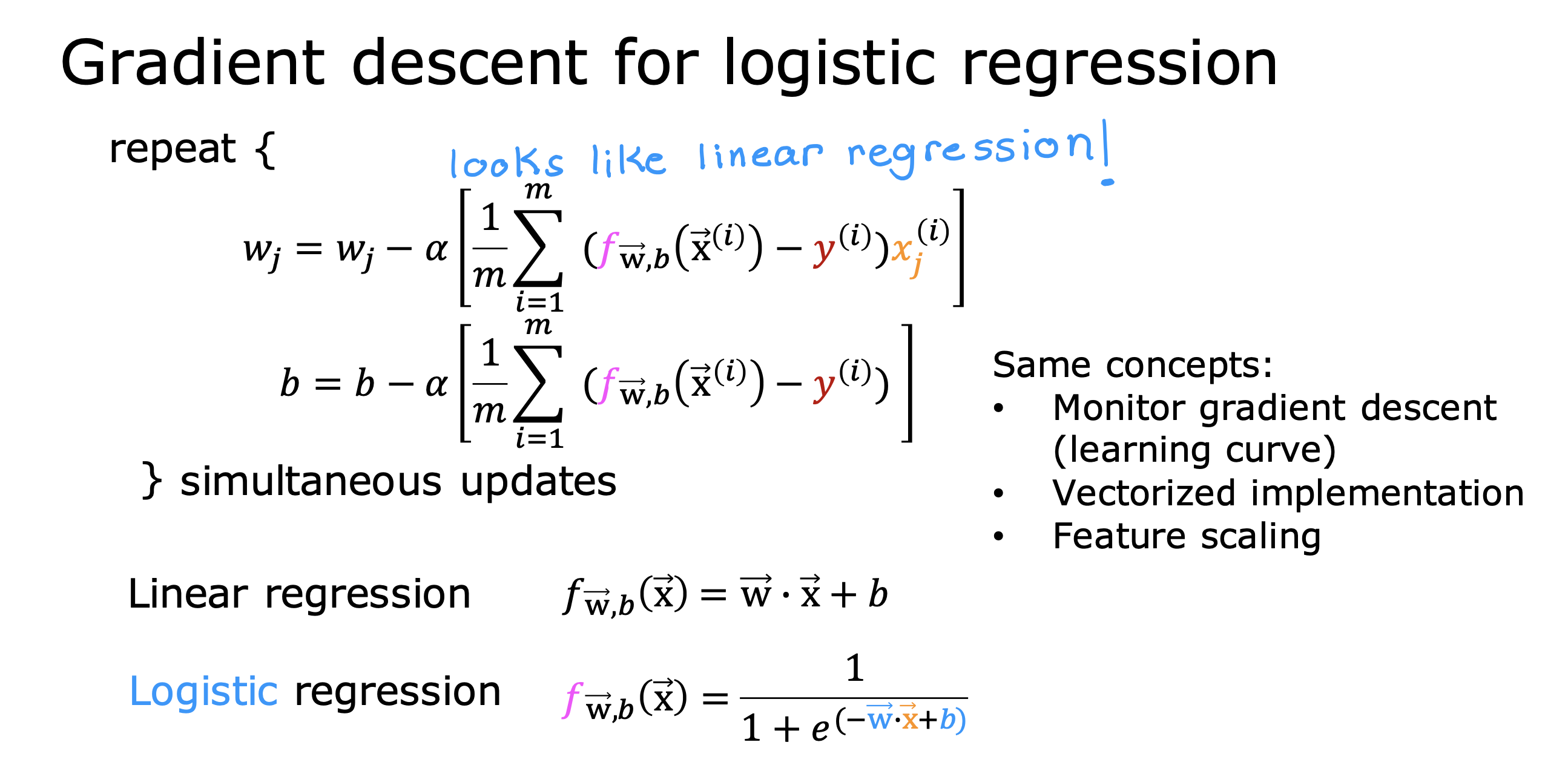

梯度下降找到w&b