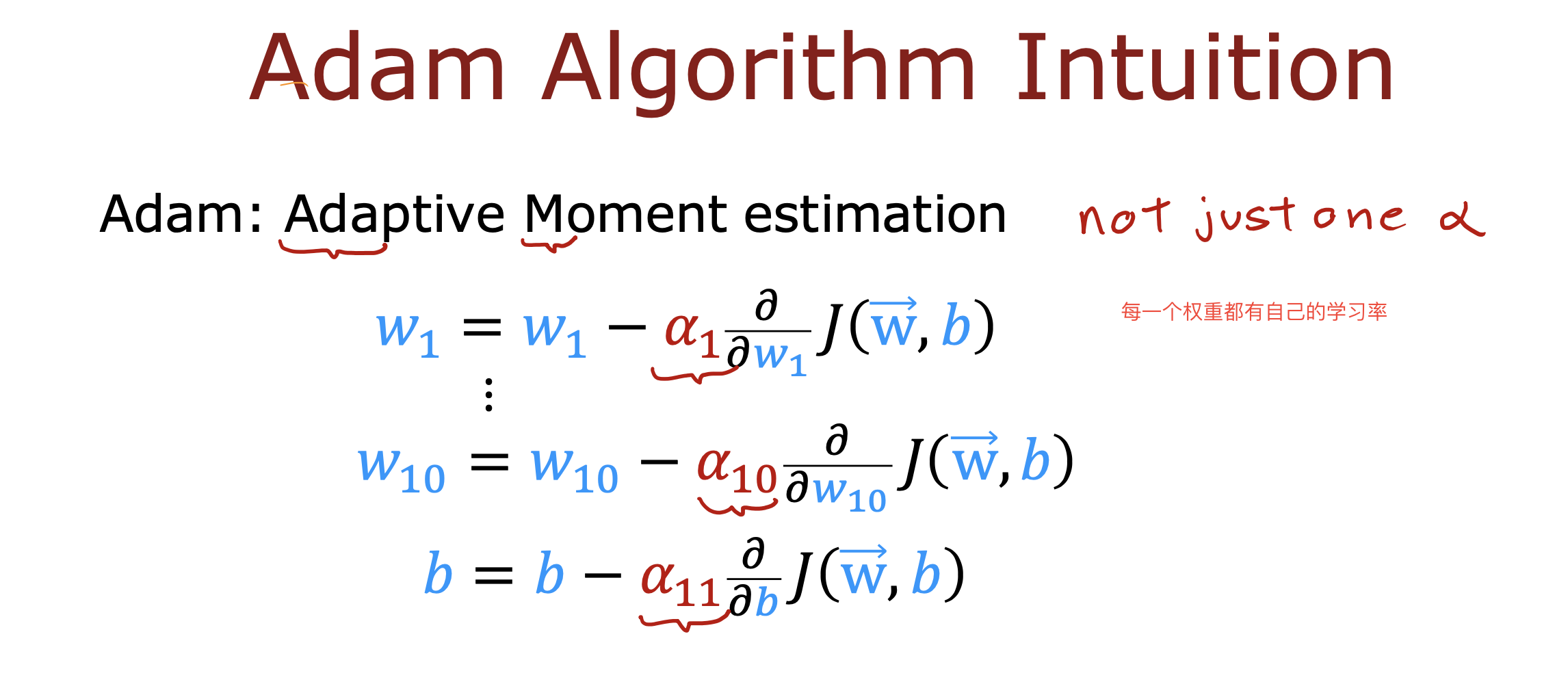

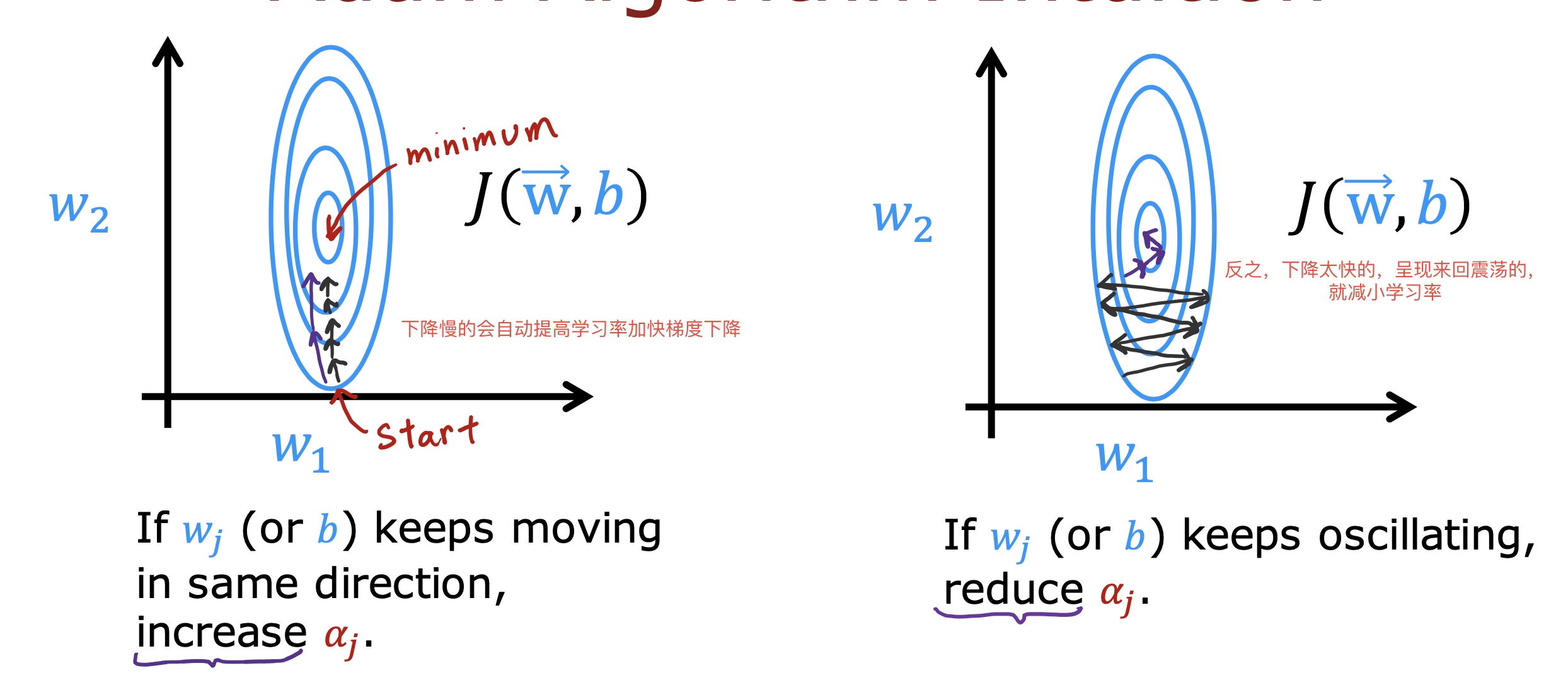

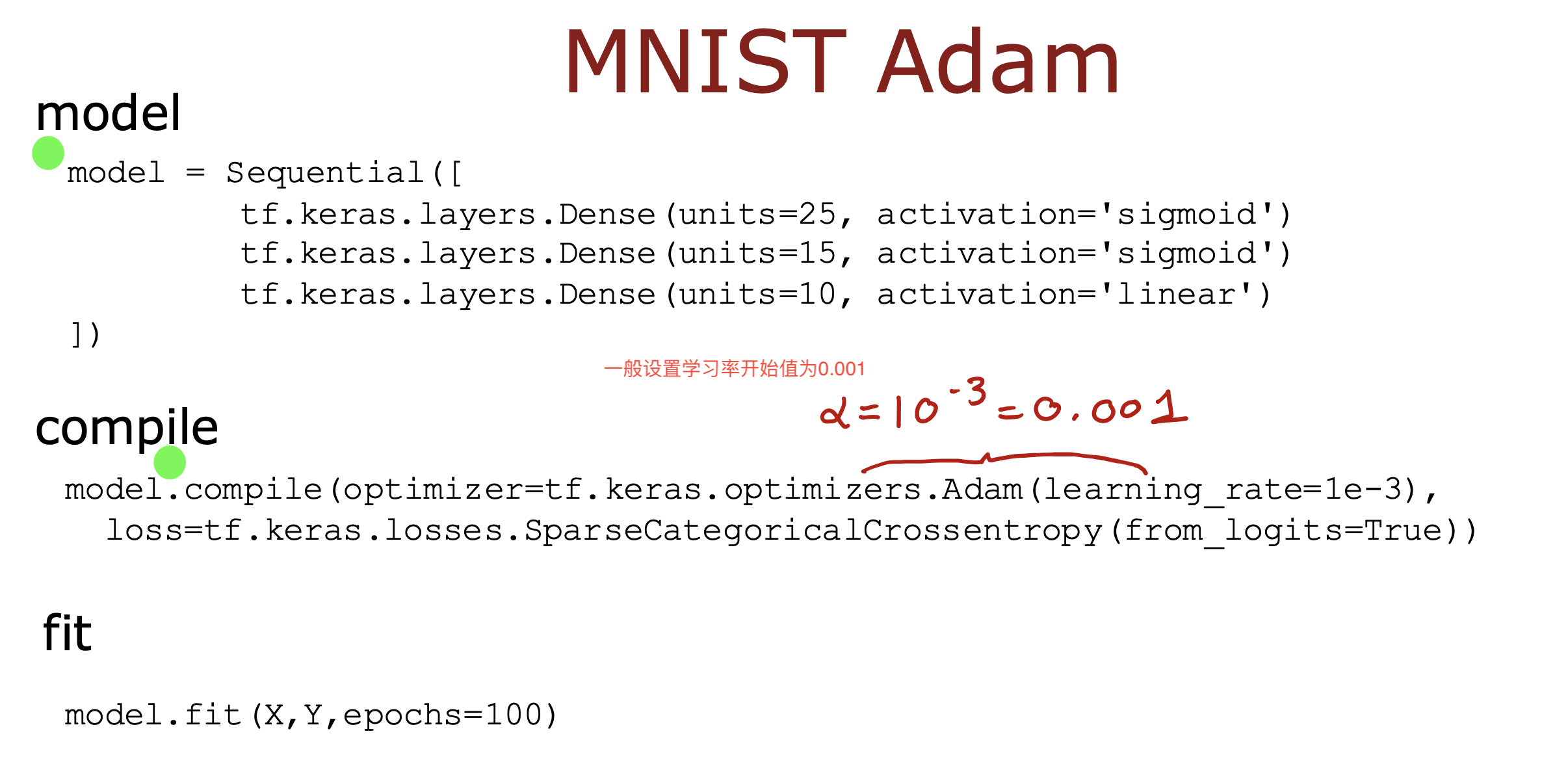

Adam Algorithm

一种加快模型学习的优化算法

可以自动调节学习率的大小,使模型更快的朝梯度下降的方向学习

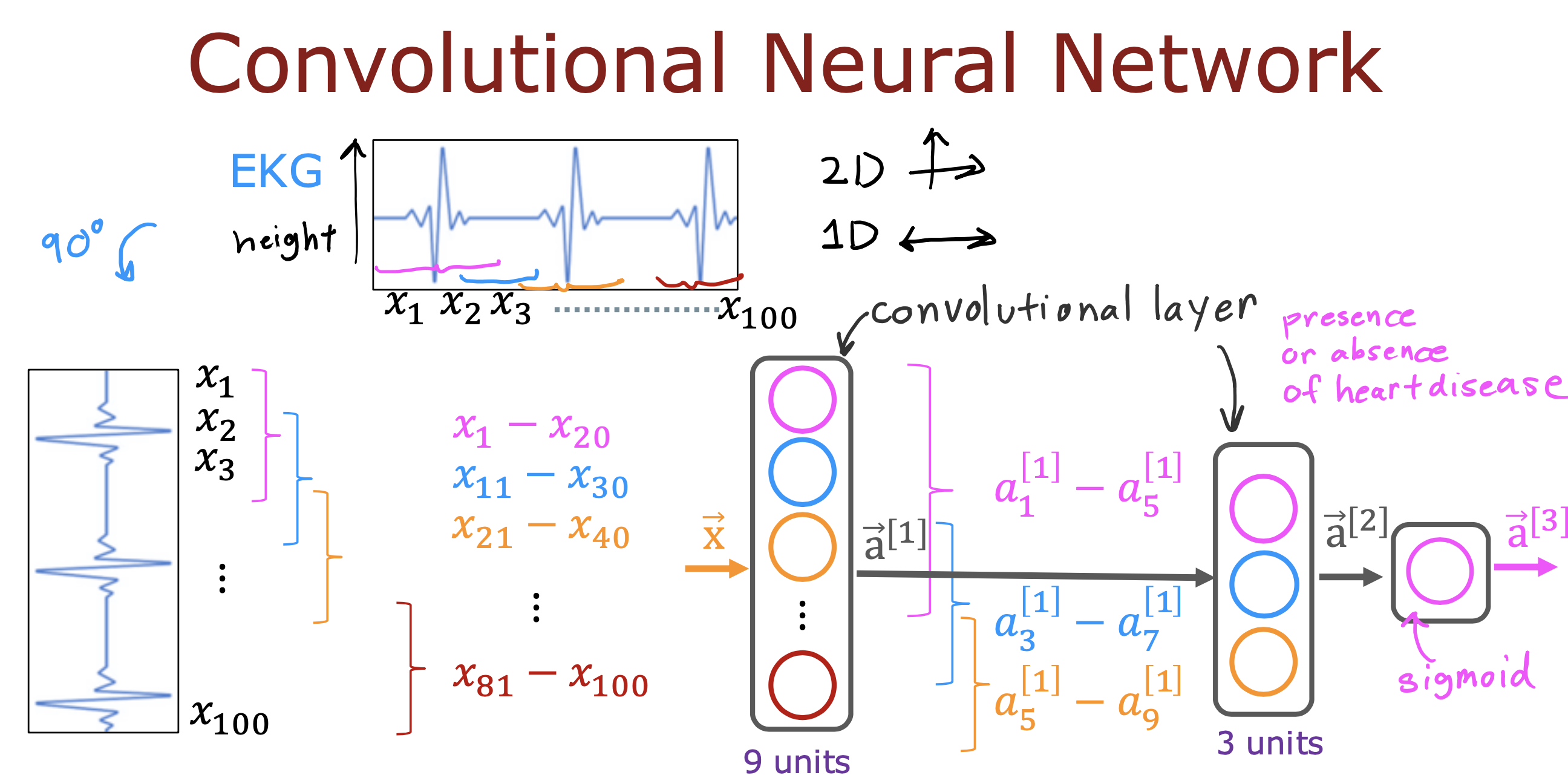

卷积层

之前讨论的神经网络中的中间层,都依赖上一层所有的输出进行计算

Each neuron output is a function of

all the activation outputs of the previous layer.

有一种计算方案是只选取上一层的部分数据计算本层的输出

这种layer 被称为卷积层(Convolutional Layer)

优点有两个

一个是可以加快计算,

另外一个是可以减少需要的训练数据

降低预测结果错误率

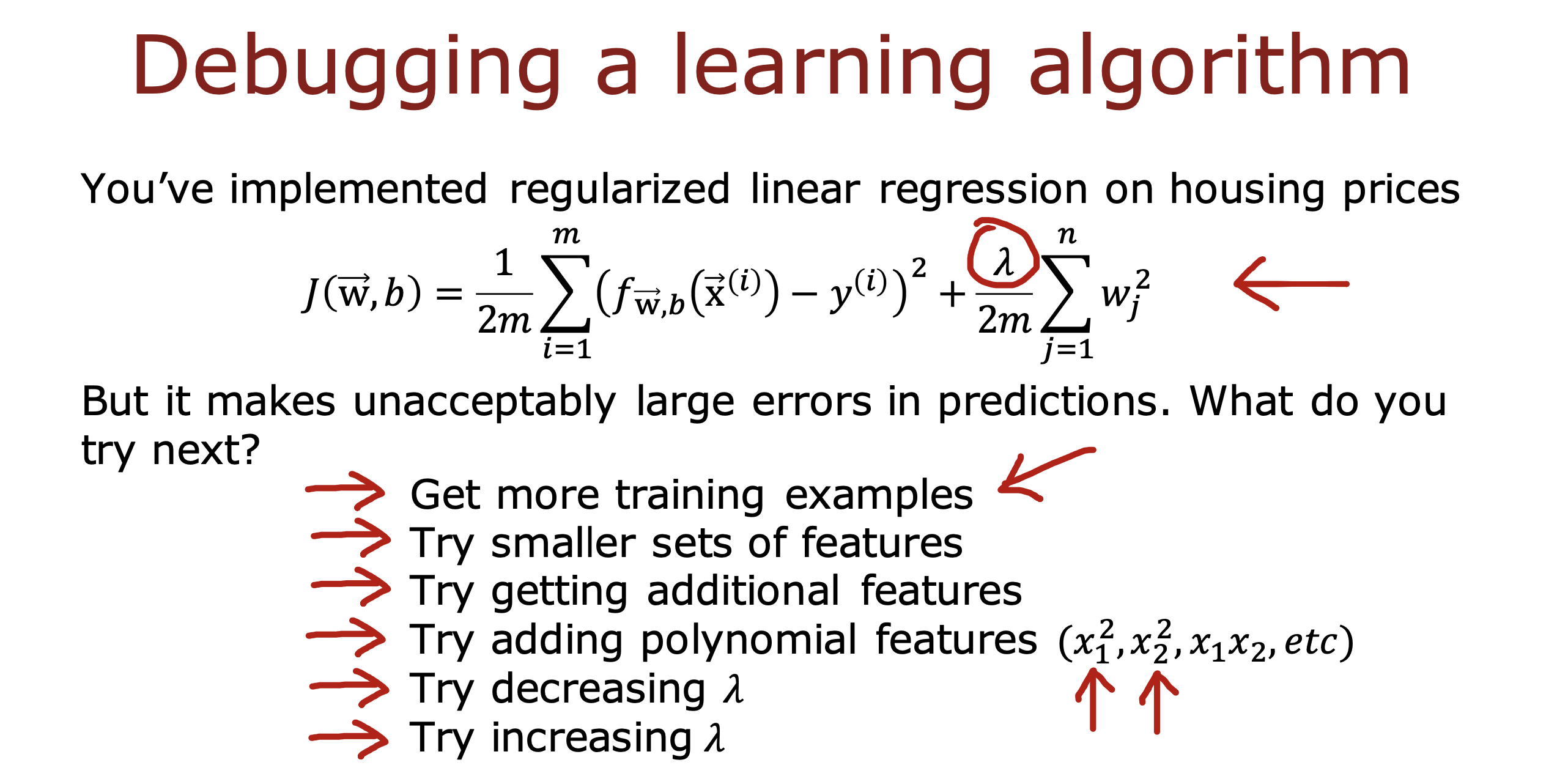

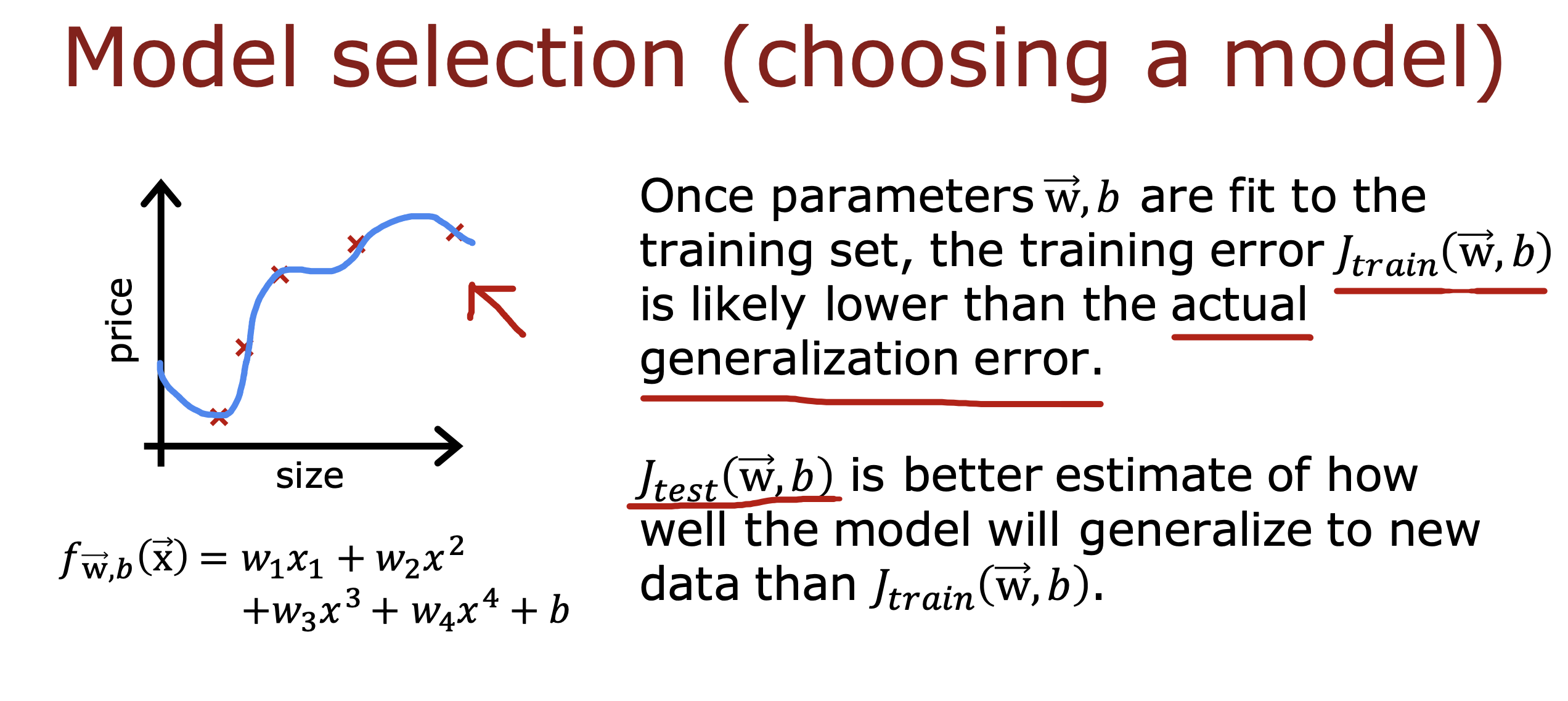

拿到训练模型后,如果遇到一个不可接受的错误输出,可以通过以下方式进行重新调整

更常见的方式是用诊断的方式评估模型好坏

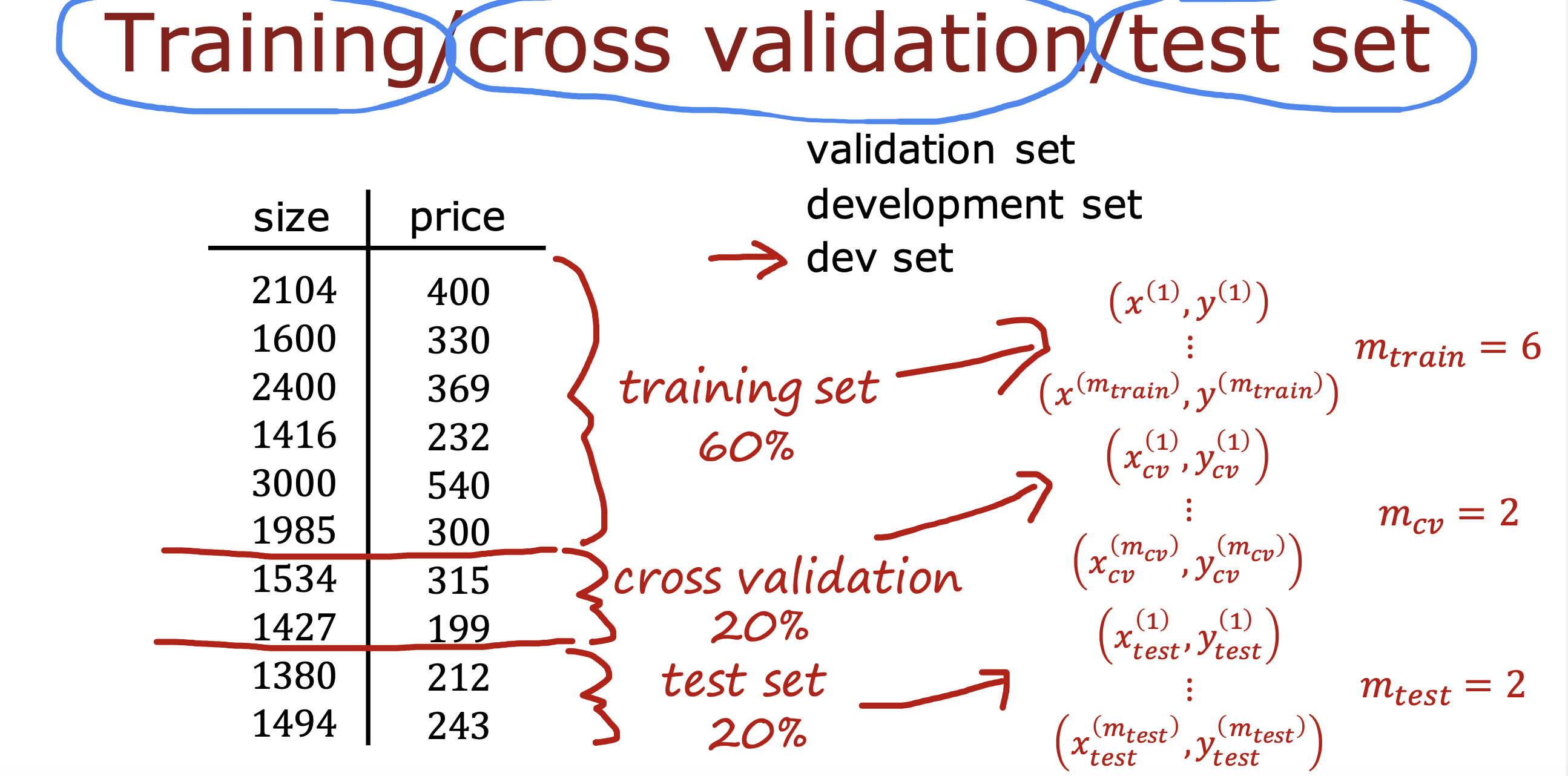

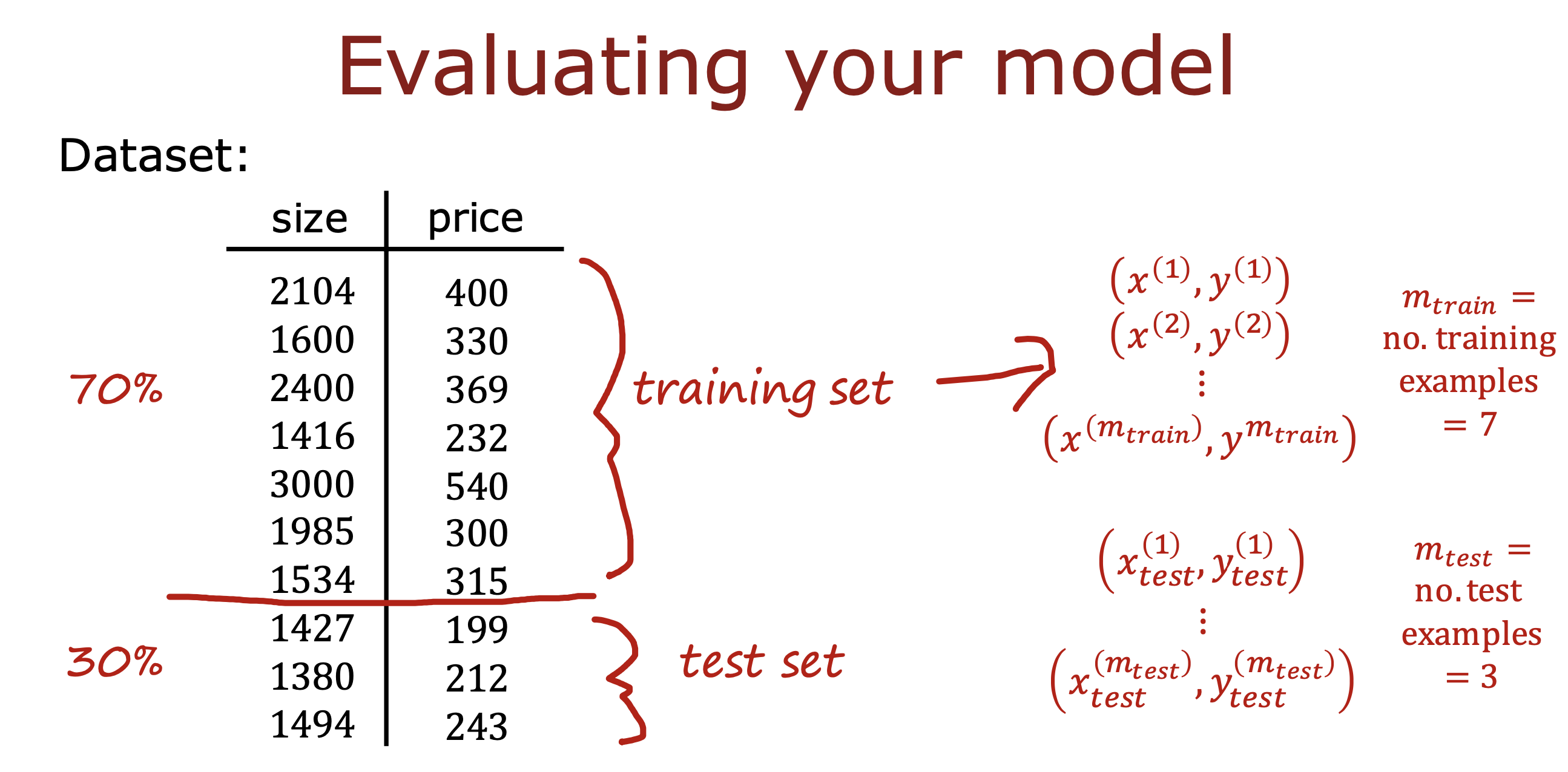

在训练前将数据分成两组,

一组用于模型训练,称为训练组

另一组用于测试训练得到的模型,称为测试组

比如对于过拟合的情况

将数据分成两组

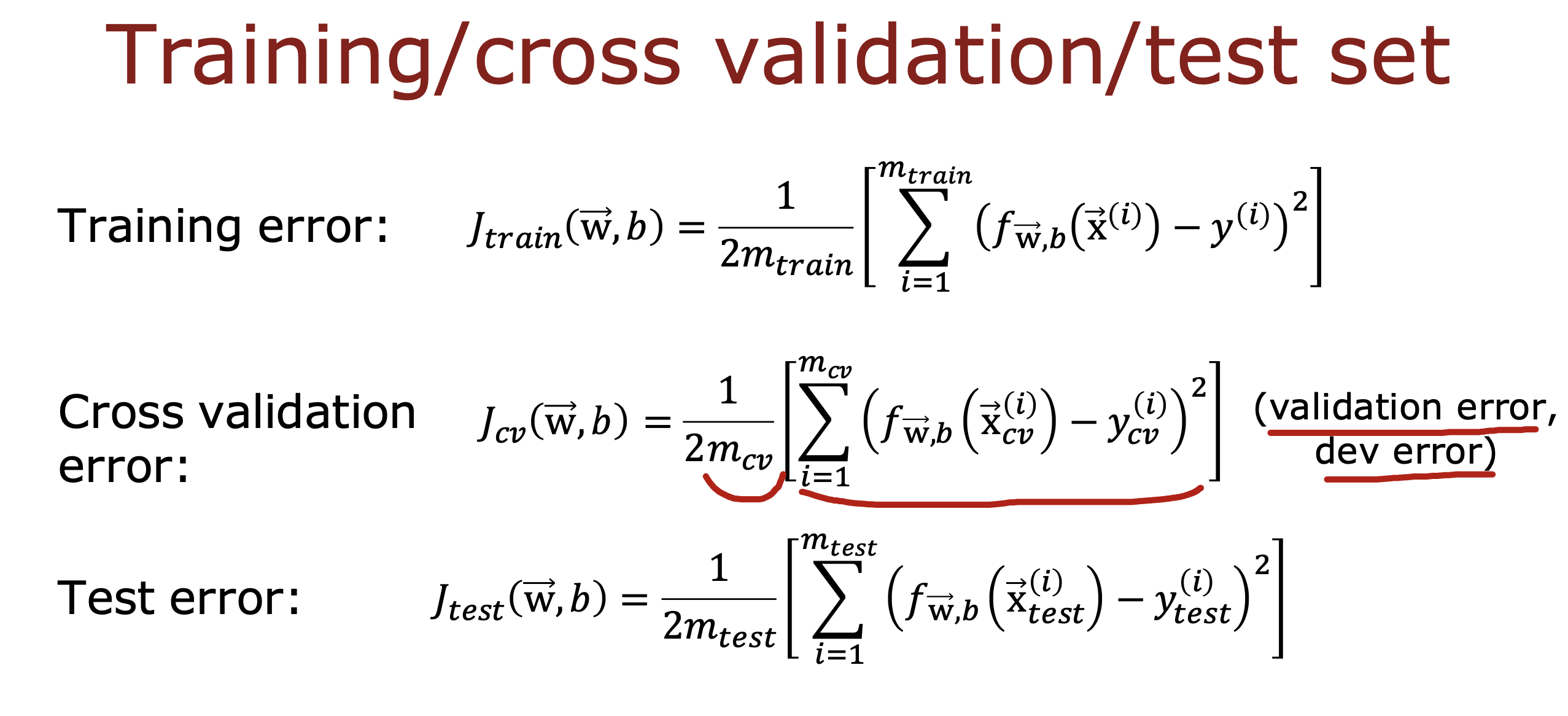

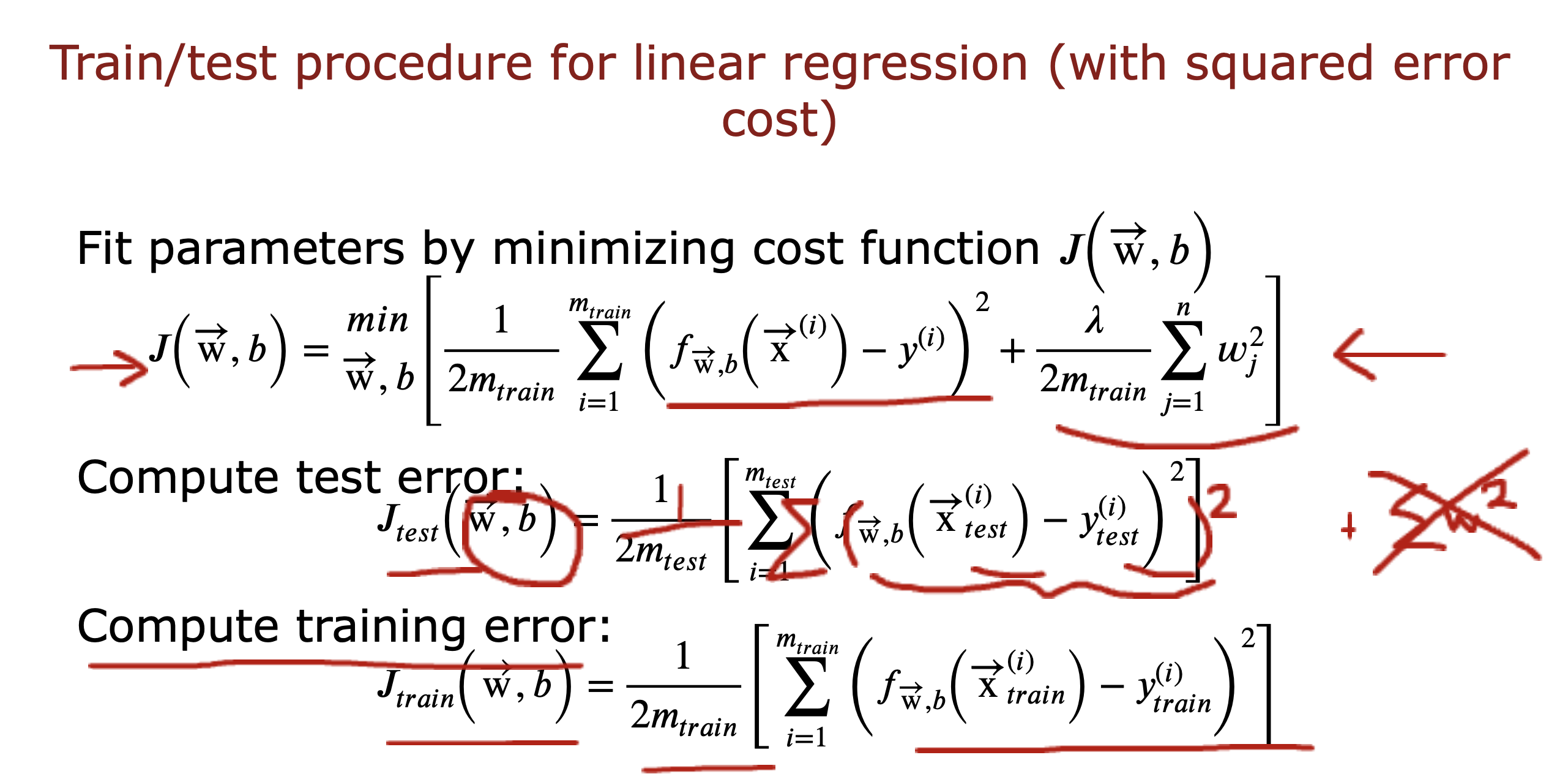

分别计算训练组和测试组的损失函数

对于训练组数据的损失函数肯定会更小

要关注的是测试数据的损失函数,值越小,说明越近真实的值,说明模型越好

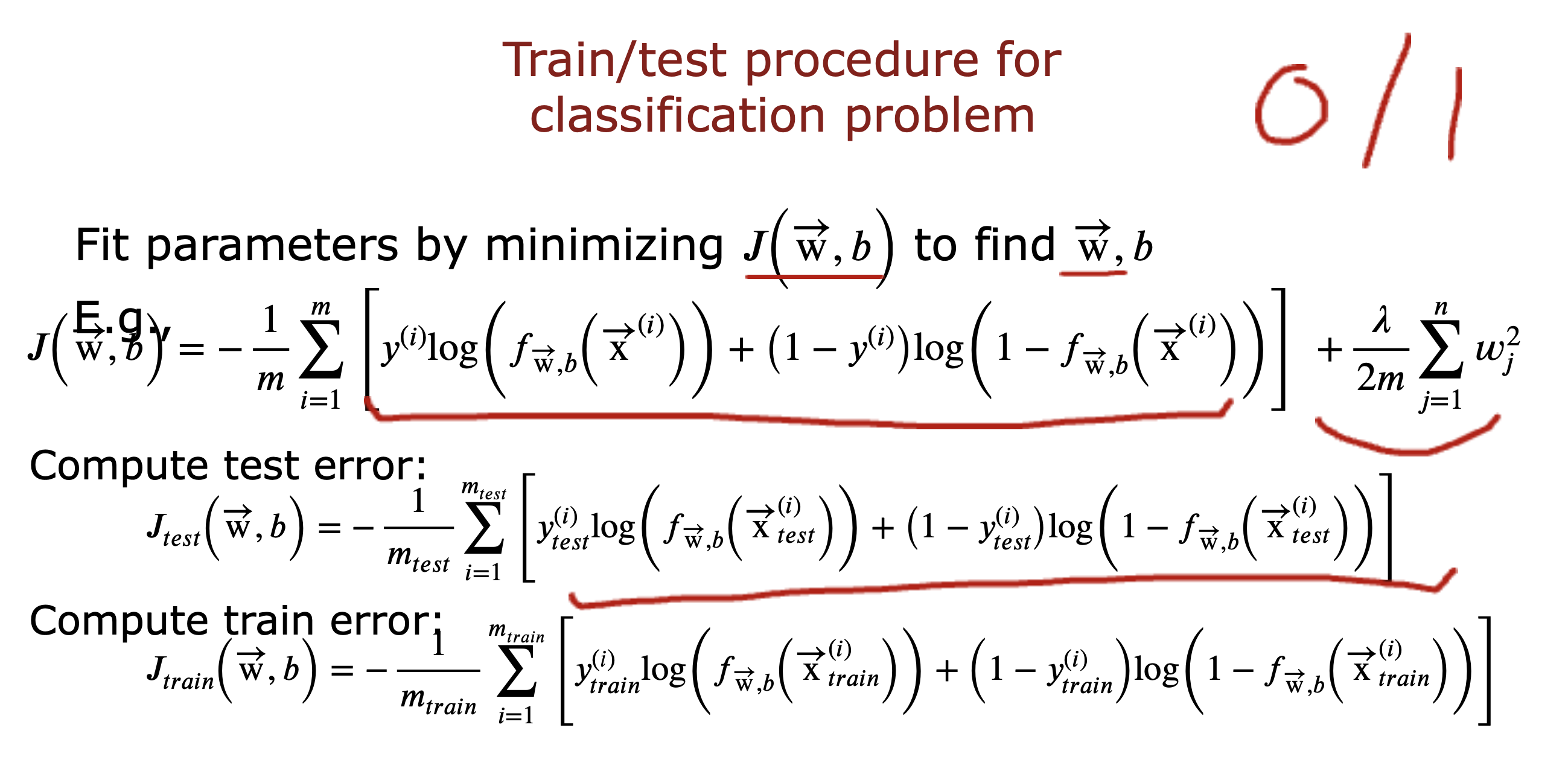

上面是线性回归模型,下面是对于分类问题的损失函数计算

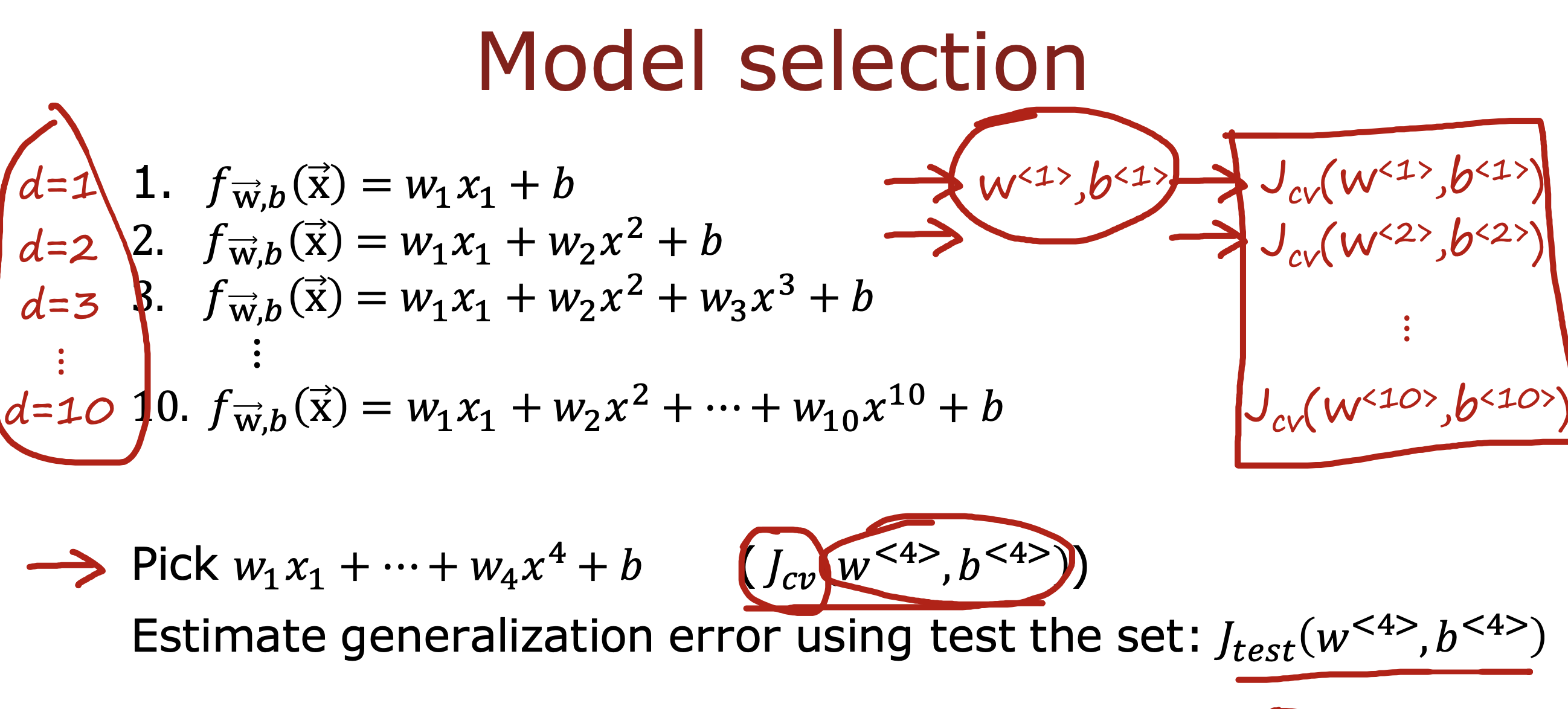

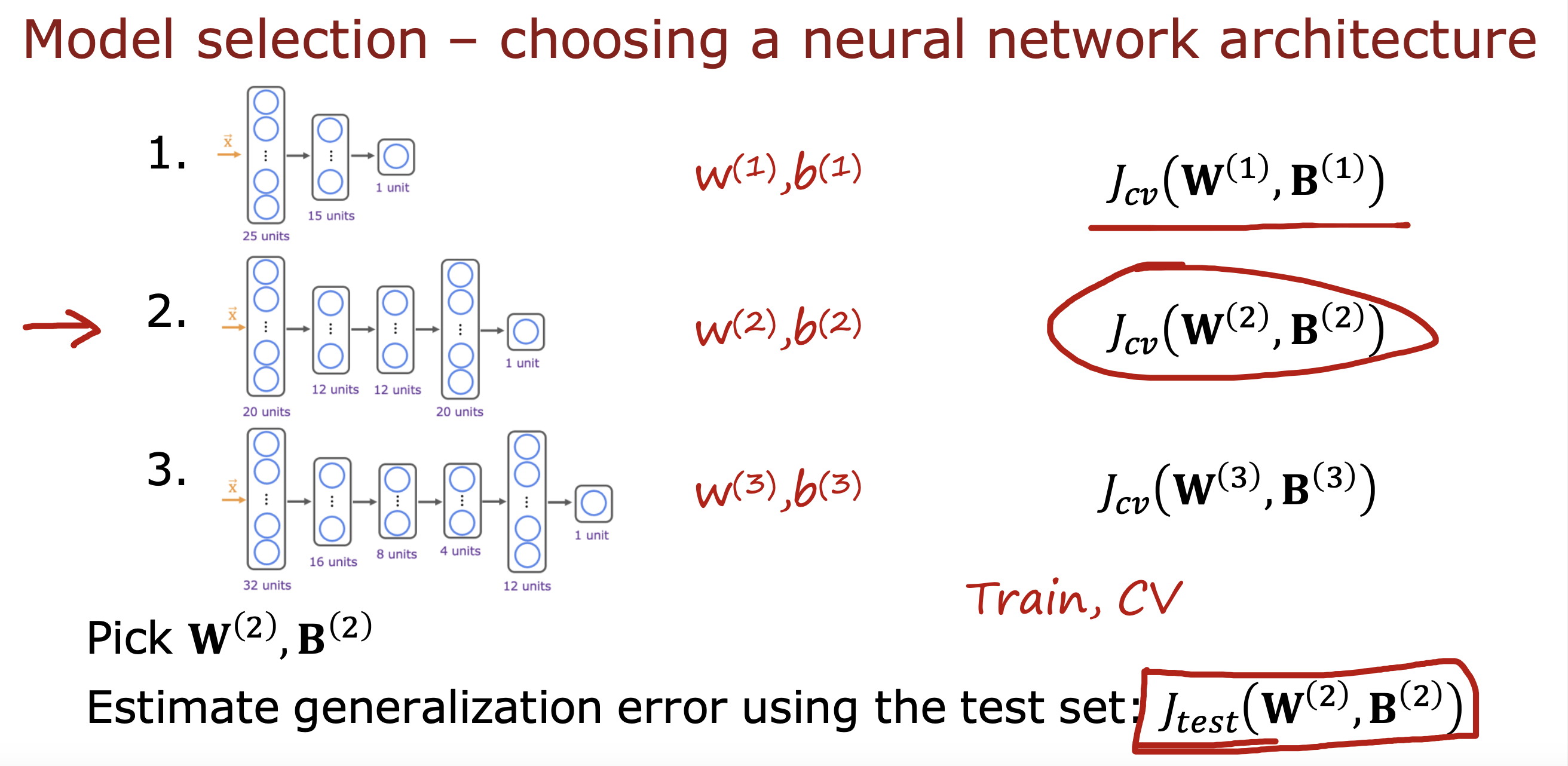

如果需要在多个模型间进行选择,可以在一开始的时候将数据分成三组

训练组,交叉验证组,测试组

同样计算基于交叉验证组数据的损失函数,值越小说明越符合实际数据

主要作用是用于选择模型,比如挑出最合适的多项式

然后再使用测试组数据进行泛化错误的测试